L’ambition européenne pour un « marché unique numérique » a généré un véritable labyrinthe de textes réglementaires que nul n’est censé ignorer, pas même les start-up et les fintech, sauf à devenir hors-la-loi. Mais à ce patchwork s’ajoute le manque de coordination entre autorités compétentes.

Par Arnaud Touati, avocat associé, et Mathilde Enouf, juriste, Hashtag Avocats

L’Union européenne a une ambition manifeste : réguler de manière exemplaire la transition numérique. Du règlement sur l’intelligence artificielle (AI Act) aux directives concernant les services numériques (DSA/DMA), en passant par la régulation des actifs numériques (MiCA) et la résilience opérationnelle du secteur financier (DORA), le législateur européen ne cesse d’introduire des normes structurantes. Chacun de ces textes, pris séparément, a pour objectif de pallier une carence. Ensemble, ils constituent un écosystème réglementaire complexe, parfois dépourvu de cohérence, souvent difficile à appliquer.

L’Union européenne a une ambition manifeste : réguler de manière exemplaire la transition numérique. Du règlement sur l’intelligence artificielle (AI Act) aux directives concernant les services numériques (DSA/DMA), en passant par la régulation des actifs numériques (MiCA) et la résilience opérationnelle du secteur financier (DORA), le législateur européen ne cesse d’introduire des normes structurantes. Chacun de ces textes, pris séparément, a pour objectif de pallier une carence. Ensemble, ils constituent un écosystème réglementaire complexe, parfois dépourvu de cohérence, souvent difficile à appliquer.

Accumulation de textes sans réelle coordination

Pour les initiatives novatrices, en particulier les start-up et les fintech, cette accumulation de normes peut rapidement devenir complexe. Cela est d’autant plus vrai que les normes et directives techniques ne cessent de croître, changeant constamment le champ de la conformité sans perspective de stabilité à moyen terme ni durabilité juridique. Actuellement, le cadre réglementaire en Europe se fonde sur plusieurs éléments-clés. L’AI Act (1) met en place une catégorisation des systèmes d’intelligence artificielle basée sur leur niveau de risque, imposant des exigences rigoureuses aux systèmes considérés comme étant « à haut risque ». Le DSA (2) et le DMA (3) ont pour objectif de réguler les grandes plateformes numériques tout en offrant une protection accrue aux utilisateurs. MiCA (4) régule la création de jetons et l’offre de services liés aux crypto-actifs. DORA (5) impose des normes rigoureuses de cybersécurité dans le domaine financier. De nombreux intervenants de l’écosystème sont également soumis aux règles (suite)

L’année 2025 va-t-elle rattraper l’année 2024 qui fut difficile pour Twitch ? Malgré un total de comptes en augmentation (plus de 21 millions de streamers actifs, dont 9,5 millions se sont inscrits l’an dernier) et des vues en hausse pour certains streamers, la plateforme championne du live streaming (jeux vidéo, e-sport et contenus en direct) diffuse moins de contenus et compte moins d’abonnements. C’est le constat dressé par la société espagnole Metricool, spécialisée dans l’analyse et la gestion des réseaux sociaux. « L’année 2024 fut difficile pour Twitch. Le géant du streaming a-t-il perdu de son élan ? », s’interroge-t-elle.

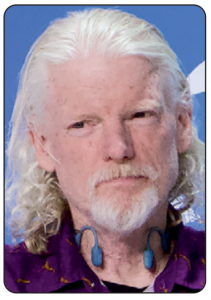

L’année 2025 va-t-elle rattraper l’année 2024 qui fut difficile pour Twitch ? Malgré un total de comptes en augmentation (plus de 21 millions de streamers actifs, dont 9,5 millions se sont inscrits l’an dernier) et des vues en hausse pour certains streamers, la plateforme championne du live streaming (jeux vidéo, e-sport et contenus en direct) diffuse moins de contenus et compte moins d’abonnements. C’est le constat dressé par la société espagnole Metricool, spécialisée dans l’analyse et la gestion des réseaux sociaux. « L’année 2024 fut difficile pour Twitch. Le géant du streaming a-t-il perdu de son élan ? », s’interroge-t-elle. Le calme avant la tempête ? Le monde du cinéma n’échappera pas au tsunami de l’intelligence artificielle. Le Festival de Cannes, qui tient sa 78e édition sur la Croisette durant presque deux semaines (13-24 mai 2025), commence à prendre en compte les films réalisés en tout ou partie par des IA génératives. L’événement international du 7e Art, organisé chaque année par l’Association française du festival international du film (AFFIF), dont Thierry Frémaux (photo) est le délégué général depuis 18 ans, inclut la « Compétition immersive » pour la seconde année consécutive.

Le calme avant la tempête ? Le monde du cinéma n’échappera pas au tsunami de l’intelligence artificielle. Le Festival de Cannes, qui tient sa 78e édition sur la Croisette durant presque deux semaines (13-24 mai 2025), commence à prendre en compte les films réalisés en tout ou partie par des IA génératives. L’événement international du 7e Art, organisé chaque année par l’Association française du festival international du film (AFFIF), dont Thierry Frémaux (photo) est le délégué général depuis 18 ans, inclut la « Compétition immersive » pour la seconde année consécutive. « Perplexity n’est pas un chabot. C’est un outil », avertit sur son site web (

« Perplexity n’est pas un chabot. C’est un outil », avertit sur son site web (