Le potentiel « champion européen » de l’IA générative, Mistral AI, a beau être valorisé près de 6 milliards d’euros depuis l’an dernier, son chiffre d’affaires 2024 est 200 fois inférieur. Pour mettre les bouchées doubles, la licorne française peut compter sur le chef de l’Etat Emmanuel Macron qui joue les VRP.

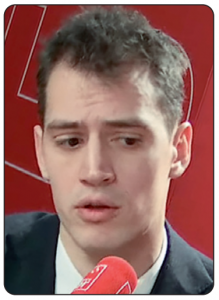

La licorne française Mistral AI, aux ambitions aussi grandes que sa valorisation de 5,8 milliards d’euros – atteinte il y a un an maintenant, à la faveur de sa dernière levée de fonds de 600 millions d’euros bouclée en juin 2024 –, a un besoin urgent de financements supplémentaires. Son PDG cofondateur Arthur Mensch (photo) l’avait confirmé à l’agence Bloomberg en février, notamment pour financer un centre de données qu’il prévoit de créer en France. « Bien sûr, en tant que start-up, on vous demande aussi de lever plus de fonds. C’est certainement un sujet qui nous préoccupe », avait-il confié (1). Le jeune patron (32 ans) avait annoncé ce projet de data center au journal de 20h de TF1, le 9 février (2). De plusieurs milliers de mètres carrés, il sera construit dans l’Essonne (département du sud de Paris), sur le plateau de Saclay, pour un investissement de « plusieurs milliards d’euros ». Si le calendrier de construction et d’ouverture reste à préciser, ce centre de données va permettre à « la pépite française » d’entraîner sur le sol français – au nom de la « souveraineté numérique » de la France – ses grands modèles de langage pour ses IA génératives. Mais cela suppose donc une prochaine levée de fonds pour Mistral AI, qui n’a généré en 2024 que 30 millions d’euros de chiffre d’affaires, si l’on en croit le site Sifted.eu du Financial Times spécialisé dans les start-up (3). C’est à des années-lumière des 10 milliards de dollars annualisés que l’américain OpenAI (dont ChatGPT) a atteint en juin 2025 (4).

La licorne française Mistral AI, aux ambitions aussi grandes que sa valorisation de 5,8 milliards d’euros – atteinte il y a un an maintenant, à la faveur de sa dernière levée de fonds de 600 millions d’euros bouclée en juin 2024 –, a un besoin urgent de financements supplémentaires. Son PDG cofondateur Arthur Mensch (photo) l’avait confirmé à l’agence Bloomberg en février, notamment pour financer un centre de données qu’il prévoit de créer en France. « Bien sûr, en tant que start-up, on vous demande aussi de lever plus de fonds. C’est certainement un sujet qui nous préoccupe », avait-il confié (1). Le jeune patron (32 ans) avait annoncé ce projet de data center au journal de 20h de TF1, le 9 février (2). De plusieurs milliers de mètres carrés, il sera construit dans l’Essonne (département du sud de Paris), sur le plateau de Saclay, pour un investissement de « plusieurs milliards d’euros ». Si le calendrier de construction et d’ouverture reste à préciser, ce centre de données va permettre à « la pépite française » d’entraîner sur le sol français – au nom de la « souveraineté numérique » de la France – ses grands modèles de langage pour ses IA génératives. Mais cela suppose donc une prochaine levée de fonds pour Mistral AI, qui n’a généré en 2024 que 30 millions d’euros de chiffre d’affaires, si l’on en croit le site Sifted.eu du Financial Times spécialisé dans les start-up (3). C’est à des années-lumière des 10 milliards de dollars annualisés que l’américain OpenAI (dont ChatGPT) a atteint en juin 2025 (4).

Prochaine levée de fonds indispensable

Comme la licorne n’est, par définition, pas cotée en Bourse, elle ne publie pas ses comptes et ne divulgue pas non plus ses résultats financiers. Contactée par Edition Multimédi@, la direction de Mistral AI n’a pas souhaité nous indiquer ni ses revenus ni ses prévisions. Le 7 mai dernier, à l’occasion du lancement de « Le Chat Enterprise » (assistant conversationnel dont la version grand public « Le Chat » a été lancée en février), Arthur Mensch s’est voulu rassurant quant à la (suite)

Les ChatGPT, Claude, Perplexity, Meta Ai et bien d’autres intelligences génératives vont devoir mettre la main au portefeuille pour rémunérer équitablement les auteurs et les créateurs lorsqu’elles utilisent leurs œuvres. Trois organismes ont chacun publié leur rapport dans le courant du mois de mai 2025 : l’US Copyright Office (USCO) aux Etats-Unis le 9 mai, l’Office de l’Union européenne pour la propriété intellectuelle (EUIPO) en Europe le 12 mai et le Conseil supérieur de la propriété littéraire et artistique (CSPLA) en France le 16 mai.

Les ChatGPT, Claude, Perplexity, Meta Ai et bien d’autres intelligences génératives vont devoir mettre la main au portefeuille pour rémunérer équitablement les auteurs et les créateurs lorsqu’elles utilisent leurs œuvres. Trois organismes ont chacun publié leur rapport dans le courant du mois de mai 2025 : l’US Copyright Office (USCO) aux Etats-Unis le 9 mai, l’Office de l’Union européenne pour la propriété intellectuelle (EUIPO) en Europe le 12 mai et le Conseil supérieur de la propriété littéraire et artistique (CSPLA) en France le 16 mai. Le calme avant la tempête ? Le monde du cinéma n’échappera pas au tsunami de l’intelligence artificielle. Le Festival de Cannes, qui tient sa 78e édition sur la Croisette durant presque deux semaines (13-24 mai 2025), commence à prendre en compte les films réalisés en tout ou partie par des IA génératives. L’événement international du 7e Art, organisé chaque année par l’Association française du festival international du film (AFFIF), dont Thierry Frémaux (photo) est le délégué général depuis 18 ans, inclut la « Compétition immersive » pour la seconde année consécutive.

Le calme avant la tempête ? Le monde du cinéma n’échappera pas au tsunami de l’intelligence artificielle. Le Festival de Cannes, qui tient sa 78e édition sur la Croisette durant presque deux semaines (13-24 mai 2025), commence à prendre en compte les films réalisés en tout ou partie par des IA génératives. L’événement international du 7e Art, organisé chaque année par l’Association française du festival international du film (AFFIF), dont Thierry Frémaux (photo) est le délégué général depuis 18 ans, inclut la « Compétition immersive » pour la seconde année consécutive. « Perplexity n’est pas un chabot. C’est un outil », avertit sur son site web (

« Perplexity n’est pas un chabot. C’est un outil », avertit sur son site web (