Il y a un an, la Cnil mettait en demeure une première société française éditrice d’un site web utilisant Google Analytics, jugé incompatible avec le RGPD quant au transfert des données vers les Etats-Unis. Deux autres sociétés ont été aussi épinglées sur les 101 plaintes de l’association Noyb.

Il y a plus de trois mois, Russell Ketchum (photo de gauche), directeur de Google Analytics, confirmait qu’Universal Analytics sera remplacé 1er juillet 2023 par la version 4 de Google Analytics (GA4), tandis qu’« Universal Analytics 360 » sera, lui, finalement prolongé jusqu’au 1er juillet 2024 (

1), soit au-delà du 1er octobre 2023 initialement prévu (

2). Quésaco ? Universal Analytics est la version basique et gratuite de l’outil de mesure d’audience le plus utilisé au monde par des sites web et des applications mobiles.

Le transfert des données vers les USA

Google Analytics détient en effet 86,1 % de parts de marché au 7 février 2023 en étant utilisé par 56,5 % de tous les sites web, selon W3Techs, suivi par Facebook Pixel et de bien d’autres analyseurs de trafic (

3). « Universal Analytics 360 » est, elle, la version premium payante de Google Analytics destinée principalement aux grandes entreprises.

Edition Multimédi@ a demandé à Google si GA4 répondait aux préoccupations des Européens sur la protection de leur vie privée, conformément au règlement général sur la protection des données (RGPD), et notamment aux mises en demeure prononcées par la Cnil en décembre 2021 et en décembre 2022 ? « Nous avons en effet récemment introduit de nouvelles fonctionnalités pour Google Analytics 4 qui permettent par exemple aux sites web de ne pas enregistrer ni stocker les adresses IP via GA4, ou encore de minimiser les données collectées concernant l’utilisateur, ce qui peut ainsi aider à répondre aux préoccupations d’identification des utilisateurs. Cependant, le véritable problème au cœur de tout cela reste les transferts de données entre l’Union européenne et les Etats-Unis qui manquent d’un cadre juridique stable pour les entreprises européennes et américaines », nous a répondu le géant du Net. Et d’ajouter : « Nous considérons que l’Executive Order récent[d’octobre 2022, ndlr] de la Maison Blanche est une étape importante dans ce travail » (

4). De quoi rassurer les éditeurs de sites web et d’applis mobiles utilisant Google Analytics et les « Cnil » en Europe qui les surveillent voire les sanctionnent ? Rien n’est moins sûr. Il y a un an en France, le 10 février 2022, la Cnil mettait en demeure la toute première société pour non-respect du RGPD pour l’utilisation de Google Analytics pour mesurer son audience web (

5). La Cnil considère implicitement que Google Analytics est ni plus ni moins illégal au regard du RGPD pour deux motifs principaux : les mesures mises en place par Google ne sont pas suffisantes pour exclure la possibilité d’un accès aux données de résidents européens ; les données des internautes européens sont donc transférées illégalement vers les Etats-Unis par le biais de ce même outil. Cette première décision de la Cnil a été publiée il y a un an, mais de façon anonymisée, pour l’exemple (

6). Mais il s’agit de l’une des trois sociétés françaises utilisant Google Analytics contre lesquelles l’organisation autrichienne Noyb dirigée par Max Schrems (photo de droite) avait déposé plaintes – parmi un total de 101 plaintes (

7) déposées en août 2020 – auprès des « Cnil » européennes, dénonçant des transferts illégaux de données à caractère personnel vers les Etats-Unis.

La Cnil en France avait ainsi été destinataire de trois plaintes à l’encontre de respectivement Decathlon, Auchan et Sephora. Parallèlement, concernant cette fois l’outil Facebook Connect, la Cnil était aussi saisie de trois autres plaintes à l’encontre de Free Mobile, Leroy Merlin et Le Huffington Post. Après sa première décision concernant Google Analytics, la Cnil mettra également en demeure les deux autres sites web mis en cause (parmi Decathlon, Auchan et Sephora). Ce dont se félicitera à nouveau la Noyb le 5 avril 2022 dans un communiqué où sont mises en ligne les deux autres décisions de la Cnil, là aussi anonymisées (

8). Ces trois sociétés disposaient d’un délai d’un mois – renouvelable à leur demande – pour se mettre en conformité et justifier cette conformité auprès de la Cnil.

Mais la Cnil n’a pas été la première à épingler les éditeurs de services en ligne qui utilisent Google Analytics. Son homologue autrichienne – la Datenschutzbehörde (DSB) – avait ouvert la voie deux semaines avant dans une décision inédite datée du 22 décembre 2021 et considérée comme « révolutionnaire » par la Noyb (

9).

L’Italie, la Grèce mais pas l’Espagne

Ce fut la première fois en Europe que l’utilisation de Google Analytics est considérée comme une violation du RGPD. D’autres décisions ont été prises par d’autres autorités en Europe – la Grèce par décision de l’APD de janvier 2022 (

10) et l’Italie par décision de la GPDP de juin 2022 (

11) – à l’encontre de l’utilisation de « GA ». En revanche, la « Cnil » espagnole – l’AEDP – n’a pas suivi ni ses homologues européennes ni la CEPD en publiant le 15 décembre 2022 une décision rejetant la plainte de Noyb (

12). Ces premières décisions sur les 101 plaintes déposées par Noyb faisaient suite à la décision de 2020 dite « Schrems II » de la Cour de justice de l’Union européenne (CJUE) estiment que l’utilisation des services Internet américains violait le RGPD, car les lois de surveillance américaines exigent que les Google, Facebook et autres Twitter fournissent aux autorités américaines des détails personnels sur leurs utilisateurs, mêmes Européens.

Le spectre de la loi américaine FISA

Par exemple, la loi américaine FISA – Foreign Intelligence Surveillance Act – autorise expressément la NSA – National Security Agency – à collecter les données personnelles des utilisateurs situés hors des Etats-Unis si ces data sont stockées sur des serveurs américains. Autre texte américain, présidentiel celui-ci : l’OE – Executive Order – numéro 12.333 qui renforce les services de renseignement aux Etats-Unis depuis Ronald Reagan et George W. Bush. C’est pour ces raisons que la CJUE avait annulé en 2020 l’accord de transfert « Privacy Shield » (décision « Schrems II » de 2020), après avoir annulé l’accord précédent « Safe Harbor » (décision « Schrems I » de 2015). Cela provoqua une onde de choc pour les GAFAM qui les secouent encore aujourd’hui (

13). « Nous nous attendons à ce que des décisions similaires tombent progressivement dans la plupart des Etats membres de l’UE. Nous avons déposé 101 plaintes dans presque tous les Etats membres et les autorités [les « Cnil » européennes, ndlr] ont coordonné la réponse », s’était félicité Max Schrems. Il est prêt à attaquer à nouveau devant la CJUE la nouvelle décision sur le transfert des données « UE-USA » (

14) publiée par la Commission européenne le 13 décembre dernier (

15). Dans la foulée de la décision de la DSB en Autriche, le Contrôleur européen de la protection des données (CEPD) – regroupant les « Cnil » européennes – avait également rendue une semaine avant une décision commune similaire (

16). S’il devait y avoir sanction, le RGPD prévoit qu’elle peut aller jusqu’à 20 millions d’euros ou 4 % du chiffre d’affaires mondial de l’entreprise du Net.

C’est justement parce que Google Analytics est largement utilisé par une écrasante majorité d’éditeurs de services en ligne que la Cnil avait décidé d’anonymiser ses trois décisions. « Il ne paraissait pas utile de citer le nom d’un éditeur de site en particulier, l’usage de cet outil étant très répandu. L’objectif est que l’ensemble des responsables de traitement utilisant cet outil se mette en conformité », justifiait ainsi le gendarme des données personnelles. Il avait d’ailleurs mis en garde tous les éditeurs concernés : « Tous les responsables de traitement utilisant Google Analytics d’une façon similaire à ces organismes doivent considérer dès à présent cette utilisation comme illégale au regard du RGPD. Ils doivent donc se tourner vers un prestataire proposant des garanties suffisantes de conformité ». D’après la Cnil, les trois sociétés mises en demeure avaient établi avec Google des clauses contractuelles types, proposées par défaut. Or ces dernières ne peuvent assurer seules un niveau de protection suffisant en cas de demande d’accès d’autorités étrangères, notamment si cet accès est prévu par des lois locales. En réponse au questionnaire envoyé par la Cnil, Google a indiqué que l’ensemble des données collectées par le biais de Google Analytics était hébergé aux Etats-Unis. Néanmoins, avait mentionné le gendarme français des données personnelles le 7 juin 2022, « Google avait indiqué avoir mis en place des mesures supplémentaires d’ordre juridique, organisationnel et technique, qui ont cependant été jugées insuffisantes pour assurer la protection effective des données personnelles transférées, en particulier contre des demandes d’accès aux données par des services de renseignement états-uniens » (

17).

La Cnil avait en outre fait savoir que Google avait indiqué utiliser des mesures de pseudonymisation (

18), mais non d’anonymisation (

19). « Google propose bien une fonction d’anonymisation des adresses IP, a constaté la Cnil, mais celle-ci n’est pas applicable à tous les transferts. En outre, les éléments fournis par Google ne permettent pas de déterminer si cette anonymisation a lieu avant le transfert aux Etats-Unis ». Autre problème que pose Google Analytics : la réidentification de l’internaute. En effet, la seule utilisation d’identifiants uniques permettant de différencier les individus peut amener à rendre les données identifiables, en particulier lorsqu’elles sont associées à d’autres informations telles que les métadonnées relatives au navigateur et au système d’exploitation.

Data et navigation : le risque de suivi demeure

De plus, l’utilisation de Google Analytics avec d’autres services de Google, notamment marketing, peut amplifier le risque de suivi. « En effet, explique la Cnil, ces services, très utilisés en France, peuvent permettre un recoupement de l’adresse IP et ainsi de retracer l’historique de navigation de la majorité des internautes sur un grand nombre de sites ». Quant au chiffrement de données par Google, il s’est avéré insuffisant car Google procède lui-même au chiffrement des données et a l’obligation d’accorder l’accès ou de fournir les données importées qui sont en sa possession, y compris les clés de chiffrement nécessaires pour les décrypter.

@

Charles de Laubier

Le e-commerçant allemand Zalando avait été désigné le 25 avril 2023 par la Commision européenne – dans le cadre du Digital Services Act (DSA) – comme « très grande plateformes » ou VLOP (1) dans le jargon bruxellois, aux côtés de Alibaba/AliExpress, Amazon Store, Apple/AppStore, Booking, Facebook, Google Play, Google Maps, Google Shopping, Instagram, LinkedIn, Pinterest, Snapchat, TikTok, Twitter, Wikipedia et YouTube, ainsi que des « très grands moteurs de recherche en ligne » ou VLOSE (2), Bing et Google Search (3). A ce « Big 19 » sont venus s’ajouter le 28 décembre 2023 trois autres VLOP, les plateformes pornographiques Pornhub, Stripchat et XVideos (4).

Le e-commerçant allemand Zalando avait été désigné le 25 avril 2023 par la Commision européenne – dans le cadre du Digital Services Act (DSA) – comme « très grande plateformes » ou VLOP (1) dans le jargon bruxellois, aux côtés de Alibaba/AliExpress, Amazon Store, Apple/AppStore, Booking, Facebook, Google Play, Google Maps, Google Shopping, Instagram, LinkedIn, Pinterest, Snapchat, TikTok, Twitter, Wikipedia et YouTube, ainsi que des « très grands moteurs de recherche en ligne » ou VLOSE (2), Bing et Google Search (3). A ce « Big 19 » sont venus s’ajouter le 28 décembre 2023 trois autres VLOP, les plateformes pornographiques Pornhub, Stripchat et XVideos (4).

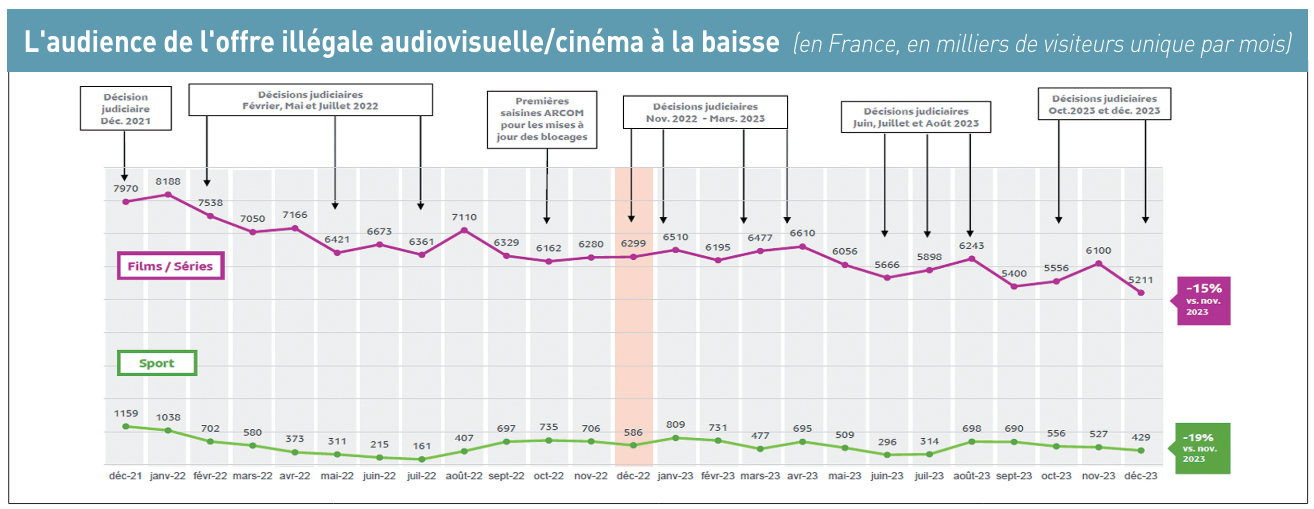

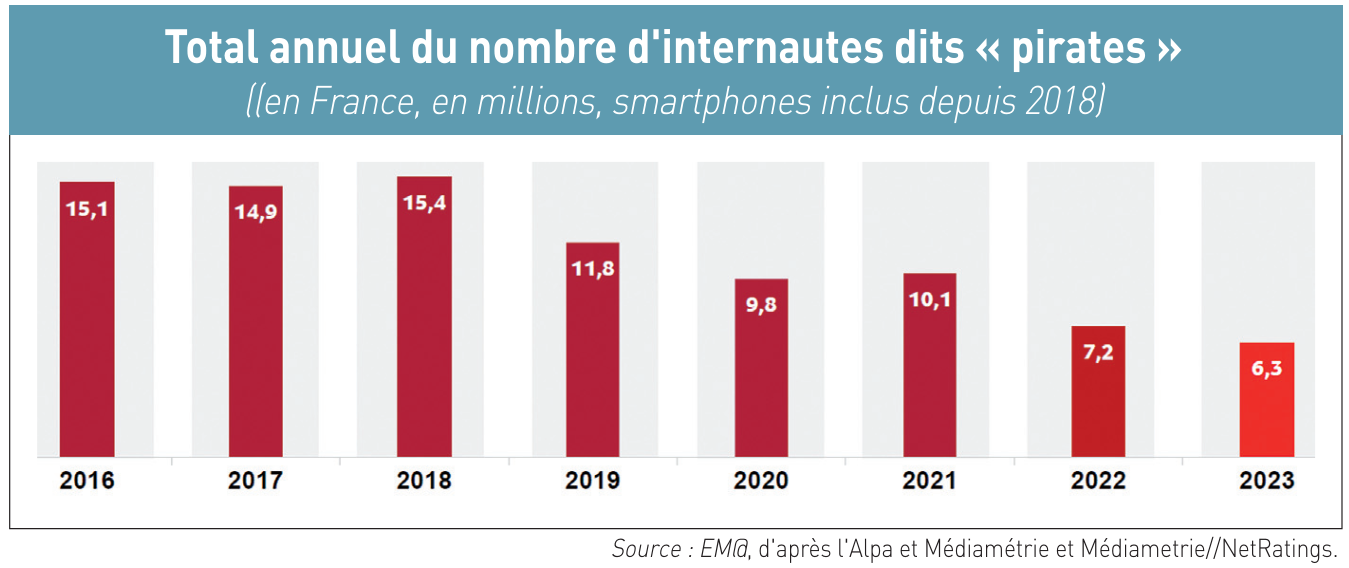

Les « cyberlockers » ont le vent en poupe et jouent au chat et à la souris avec les ayants droits, les régulateurs et les juges. En France, rien qu’en janvier 2024, ce ne sont pas moins cinq d’entre eux – Turbobit, Rapidgator, Streamtape, Upstream et Nitroflare – qui ont été bloqués par décision de justice. En un an, près d’une quinzaine de ces sites d’hébergement générateurs de liens web uniques ou multiples – des URL (Uniform Resource Locator) pour permettre de télécharger des fichiers de contenus et de les partager – ont été bloqués, sur décision du juge, par les Orange, SFR, Bouygues ou Free.

Les 25 membres de l’Alpa en lutte

Outre les cinq cyberlockers épinglés en janvier, il en a aussi été ainsi de Doodstream, Mixdrop, Vidoza et Netu par jugement de juin 2023, de Uptobox en mai 2023 (

Les « cyberlockers » ont le vent en poupe et jouent au chat et à la souris avec les ayants droits, les régulateurs et les juges. En France, rien qu’en janvier 2024, ce ne sont pas moins cinq d’entre eux – Turbobit, Rapidgator, Streamtape, Upstream et Nitroflare – qui ont été bloqués par décision de justice. En un an, près d’une quinzaine de ces sites d’hébergement générateurs de liens web uniques ou multiples – des URL (Uniform Resource Locator) pour permettre de télécharger des fichiers de contenus et de les partager – ont été bloqués, sur décision du juge, par les Orange, SFR, Bouygues ou Free.

Les 25 membres de l’Alpa en lutte

Outre les cinq cyberlockers épinglés en janvier, il en a aussi été ainsi de Doodstream, Mixdrop, Vidoza et Netu par jugement de juin 2023, de Uptobox en mai 2023 ( Le CNC pourra bientôt saisir l’Arcom

Grand argentier du cinéma, de l’audiovisuel et du multimédia (dont la création numérique sur Internet, jeu vidéo, réalité virtuelle et métavers), le CNC pourrait voir ses pouvoirs étendus aux sites miroirs par la proposition de loi « visant à conforter la filière cinématographique ». Ce texte législatif, qui a été adopté en première lecture au Sénat le 14 février dernier et est actuellement entre les mains de la commission des affaires culturelles et de l’éducation de l’Assemblée nationale (

Le CNC pourra bientôt saisir l’Arcom

Grand argentier du cinéma, de l’audiovisuel et du multimédia (dont la création numérique sur Internet, jeu vidéo, réalité virtuelle et métavers), le CNC pourrait voir ses pouvoirs étendus aux sites miroirs par la proposition de loi « visant à conforter la filière cinématographique ». Ce texte législatif, qui a été adopté en première lecture au Sénat le 14 février dernier et est actuellement entre les mains de la commission des affaires culturelles et de l’éducation de l’Assemblée nationale (

Comme la Cour de Justice de l’Union européenne (CJUE) suit souvent – à près de 80% selon les statistiques – les conclusions de son avocat général, il y a fort à parier que cela sera le cas dans l’affaire « La Quadrature du Net versus Hadopi ». En l’occurrence, le 28 septembre 2023, l’avocat général de la CJUE – le Polonais Maciej Szpunar (photo) – conclut que la conservation et l’accès à des données d’identité civile, couplées à l’adresse IP utilisée, devraient être permis lorsque ces données constituent le seul moyen d’investigation permettant l’identification d’auteurs d’infractions exclusivement constituées sur Internet.

Comme la Cour de Justice de l’Union européenne (CJUE) suit souvent – à près de 80% selon les statistiques – les conclusions de son avocat général, il y a fort à parier que cela sera le cas dans l’affaire « La Quadrature du Net versus Hadopi ». En l’occurrence, le 28 septembre 2023, l’avocat général de la CJUE – le Polonais Maciej Szpunar (photo) – conclut que la conservation et l’accès à des données d’identité civile, couplées à l’adresse IP utilisée, devraient être permis lorsque ces données constituent le seul moyen d’investigation permettant l’identification d’auteurs d’infractions exclusivement constituées sur Internet. Il y a plus de trois mois, Russell Ketchum (photo de gauche), directeur de Google Analytics, confirmait qu’Universal Analytics sera remplacé 1er juillet 2023 par la version 4 de Google Analytics (GA4), tandis qu’« Universal Analytics 360 » sera, lui, finalement prolongé jusqu’au 1er juillet 2024 (

Il y a plus de trois mois, Russell Ketchum (photo de gauche), directeur de Google Analytics, confirmait qu’Universal Analytics sera remplacé 1er juillet 2023 par la version 4 de Google Analytics (GA4), tandis qu’« Universal Analytics 360 » sera, lui, finalement prolongé jusqu’au 1er juillet 2024 (