Aiguillonnée par l’Alpa et l’Arcom, la justice française multiplie les décisions de blocage de sites pirates qui recourent aux « cyberlockers », hébergeurs générant des liens web pour permettre à leurs utilisateurs d’accéder à des fichiers de films, séries, musiques ou livres, souvent piratés.

Les « cyberlockers » ont le vent en poupe et jouent au chat et à la souris avec les ayants droits, les régulateurs et les juges. En France, rien qu’en janvier 2024, ce ne sont pas moins cinq d’entre eux – Turbobit, Rapidgator, Streamtape, Upstream et Nitroflare – qui ont été bloqués par décision de justice. En un an, près d’une quinzaine de ces sites d’hébergement générateurs de liens web uniques ou multiples – des URL (Uniform Resource Locator) pour permettre de télécharger des fichiers de contenus et de les partager – ont été bloqués, sur décision du juge, par les Orange, SFR, Bouygues ou Free.

Les 25 membres de l’Alpa en lutte

Outre les cinq cyberlockers épinglés en janvier, il en a aussi été ainsi de Doodstream, Mixdrop, Vidoza et Netu par jugement de juin 2023, de Uptobox en mai 2023 (

1), ainsi que de Uqload, Upvid, Vudeo et Fembed en janvier 2023. C’est ce que révèle une étude de l’Association de la lutte contre la piraterie audiovisuelle (Alpa), réalisée avec Médiamétrie et publiée discrètement le 7 mars dernier – communiquée, sans présentation formelle, aux membres de l’Alpa qui l’a mise en ligne sur son site web (

2). Contacté par

Edition Multimédi@, le délégué général de l’Alpa depuis plus de 21 ans, Frédéric Delacroix (photo), nous explique que « les sites pirates utilisent les cyberlockers pour héberger les contenus illicites qu’ils proposent sur leurs pages en mettant à disposition des liens – de téléchargement DDL (

3) ou de streaming – renvoyant sur ces derniers, les cyberlockers étant des services essentiels dans l’écosystème pirate et ne servant qu’à l’hébergement de contenus illicites ».

Les sites pirates et leurs sites miroirs peuvent y recourir pour brouiller les pistes en multipliant les URL. Les sites miroirs sont, eux, de nouveaux chemins d’accès via de nouveaux noms de domaine qu’utilisent les sites pirates, faisant l’objet de mesures de blocage sur leur nom de domaine initial, pour poursuivre leur activité illégale. Ces sites illégaux se nomment 1fichier.com, Yggtorrent.qa, Wawacity.autos, Papadustream.to ou encore Rapidgator.net, pour ne citer que les plus utilisés en décembre 2023 d’après Médiamétrie. « Les cyberlockers ont longtemps bénéficié du statut (favorable) d’hébergeurs, supprimant sur notification les fichiers illicites notifiés par les ayants droit, mais en favorisant leur réintroduction à l’identique en connivence avec les administrateurs pirates. Nous avons réussi à prouver que leur système économique ne reposait que sur la contrefaçon d’œuvres protégées », poursuit Frédéric Delacroix.

Le délégué général de l’Alpa rappelle que la Cour de justice de l’Union européenne (CJUE) a – dans son arrêt « Cyando/ Uploaded » du 27 juillet 2021 (

4) – édicté des principes permettant d’établir le caractère contrefaisant de ce type de cyberlocker (plateforme de partage de vidéos ou plateforme d’hébergement et de partage de fichiers). « Ce qui a permis aux ayants droit, membres de l’Alpa et à notre initiative, d’en demander le blocage en justice fin 2022 ». Et depuis 2017, les ayants droit membres de l’Alpa sont à l’initiative de décisions de justice portant sur 1.300 sites pirates à ce jour, correspondant à l’utilisation de plus de 3.400 noms de domaine. L’Alpa – association française créée il y aura 40 ans l’an prochain et présidée depuis plus de 20 ans par Nicolas Seydoux (84 ans), président de Gaumont – compte aujourd’hui vingt-cinq membres que

Edition Multimédi@ présente de façon inédite par catégorie :

• Organisations professionnelles : Association des producteurs indépendants (API), Auteurs, réalisateurs et producteurs (L’Arp), Fédération nationale des éditeurs de films (FNEF), Motion Picture Association (MPA), Société civile des producteurs de cinéma et de télévision (Procirep), Société des auteurs et compositeurs dramatiques (SACD), Société des auteurs, compositeurs et éditeurs de musique (Sacem), Syndicat de l’édition vidéo numérique (SEVN), Syndicat des producteurs indépendants (SPI), Union des producteurs de cinéma (UPC).

• Studios de cinéma : Gaumont, Paramount Picture France, Pathé Films, Sony Pictures Home Entertainment, Universal Pictures Vidéo France, Walt Disney Entertainment, Warner Bros Home Video.

• Salles de cinéma : Fédération nationale du cinéma français (FNCF), UGC (ex-Union générale cinématographique).

• Chaînes de télévision : France Télévisions, Canal+, TF1, M6 via sa Société nouvelle de distribution (SND).

• Plateforme de SVOD : Netflix.

• Autorité publique : Centre national du cinéma et de l’image animée (CNC).

L’Alpa touche des subventions publiques, notamment de la part du CNC qui est un établissement public à caractère administratif placé sous l’autorité du ministère de la Culture.

Le CNC pourra bientôt saisir l’Arcom

Le CNC pourra bientôt saisir l’Arcom

Grand argentier du cinéma, de l’audiovisuel et du multimédia (dont la création numérique sur Internet, jeu vidéo, réalité virtuelle et métavers), le CNC pourrait voir ses pouvoirs étendus aux sites miroirs par la proposition de loi « visant à conforter la filière cinématographique ». Ce texte législatif, qui a été adopté en première lecture au Sénat le 14 février dernier et est actuellement entre les mains de la commission des affaires culturelles et de l’éducation de l’Assemblée nationale (

5) a fait l’objet d’un amendement adopté en commission début février (

6). Celui-ci prévoit que les titulaires de droits ne soient plus les seuls à pouvoir saisir l’Autorité de régulation de la communication audiovisuelle et numérique (Arcom) pour lui demander d’enjoindre directement aux fournisseurs d’accès à internet (FAI) et sans passer par un juge (

7) – comme c’est cas depuis octobre 2022 – de bloquer des sites miroirs de ces sites illégaux et cyberlockers déjà condamnés par la justice. Avec la nouvelle mesure, le CNC aurai aussi la possibilité de saisir l’Arcom pour lutter contre ces sites miroirs. Les ayants droits, les organismes de gestion collective et les organismes de défense professionnelle – autrement dit « toute personne qualifiée pour agir » (

8) – pourraient aussi saisir l’Arcom sur ces sites miroirs. D’autant que les premiers résultats de cette procédure sans juge sont considérés par le régulateur et les parlementaires comme « prometteurs » au regard de « la baisse de l’audience des “galaxies” de sites miroirs ». L’Arcom aurait ainsi reçu jusqu’à maintenant plus de 600 demandes d’« actualisation de décisions de justice » qui ont lui ont permet de notifier depuis plus d’un an 770 noms de domaine aux FAI pour en empêcher l’accès.

L’audience des sites illicites baisse

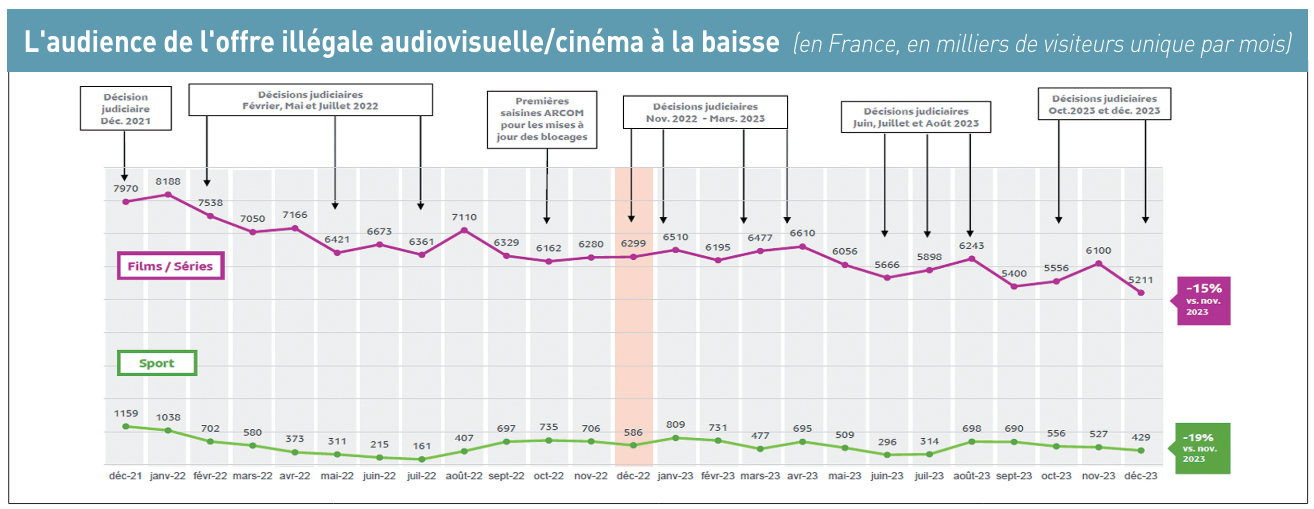

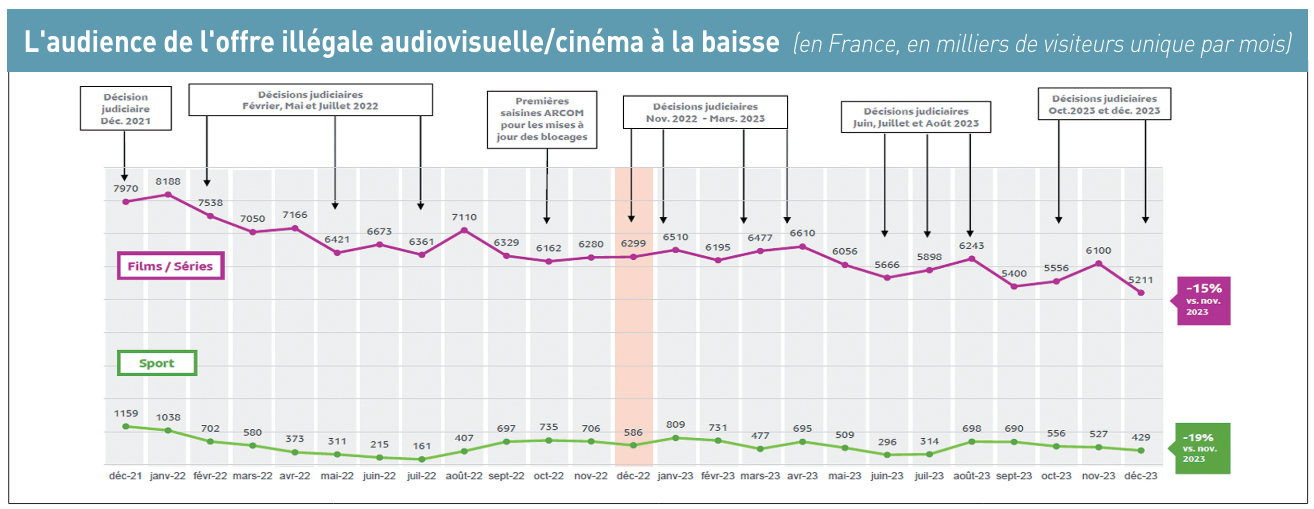

Ces jugements de blocage de cyberlockers, ordonnés le plus souvent par le tribunal judiciaire de Paris aux opérateurs télécoms et FAI contribuent – à l’instar du blocage des sites illégaux ou de leurs miroirs – à la baisse de l’audience des sites de streaming vidéo en France. A chaque décision judicaire, les audiences de ces cyberlockers et plus généralement des sites pirates ou de leurs répliques (sites miroirs) reculent de façon significative. Pour autant, la fréquentation de ces mêmes cyberlockers et/ou sites pirates peut reprendre du poil de la bête avec la mise en ligne de nouveaux sites miroirs et de nouveau liens URL, mais sans retrouver les niveaux d’avant les jugements (voir graphique plus haut).

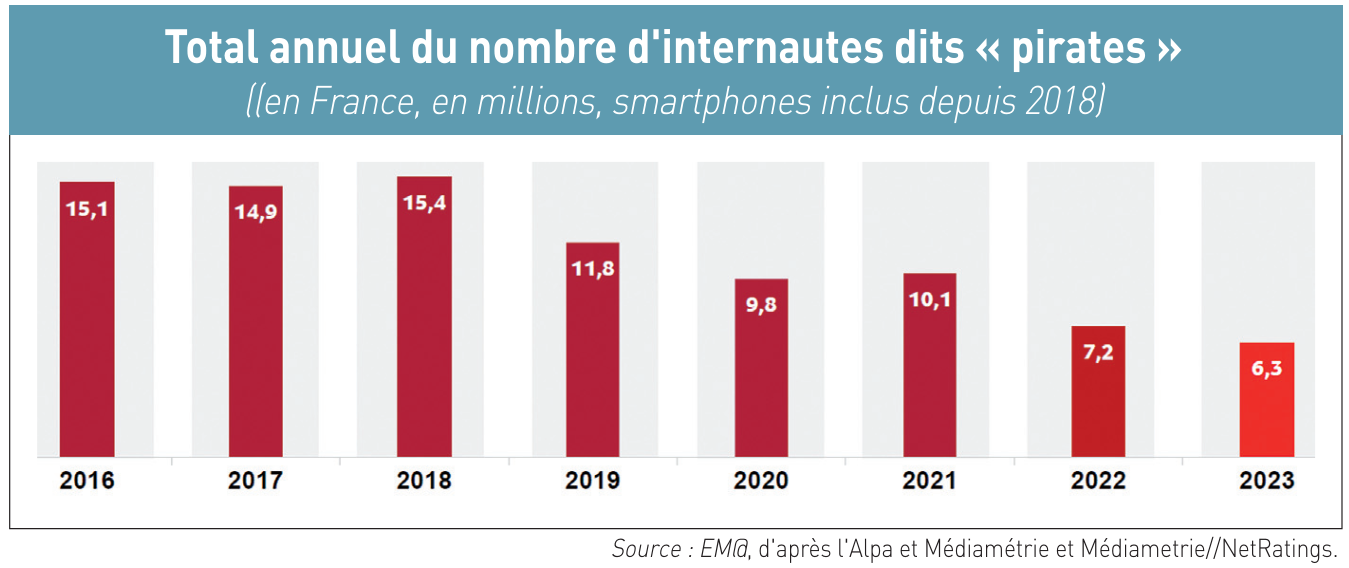

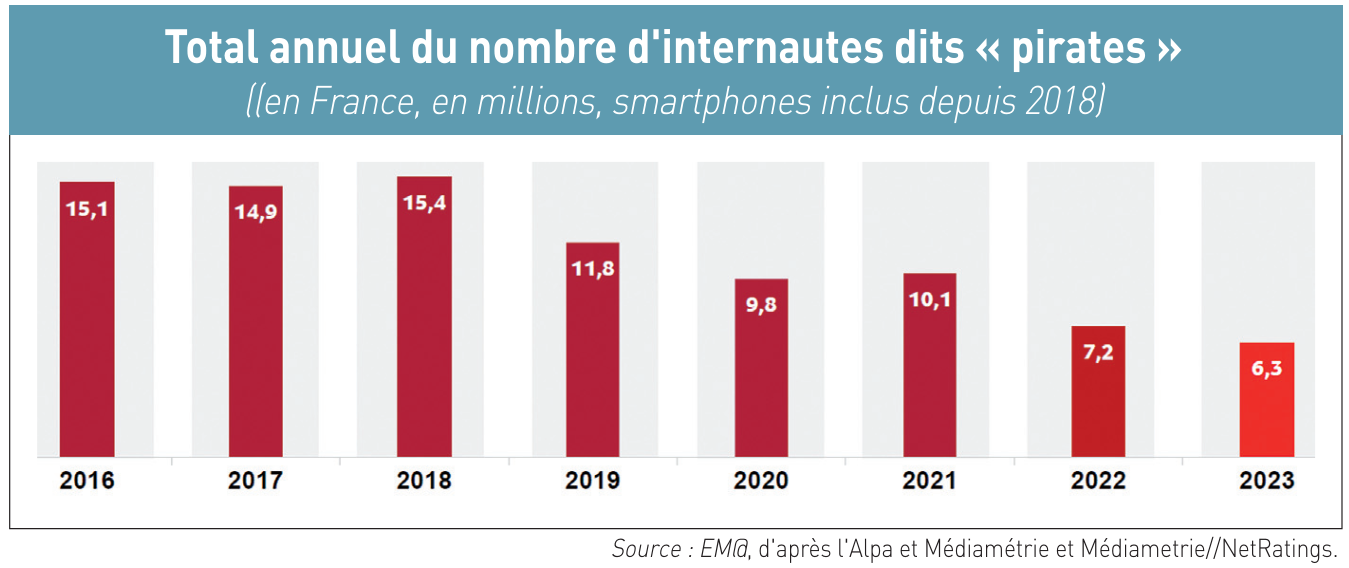

Résultat, toujours selon Médiamétrie pour l’Alpa : l’audience globale des sites illicites en France ne cesse de baisser d’année en année (sauf en 2018), passant de 15,1 millions d’« internautes pirates » en 2016 à seulement 6,3 millions en 2023. Si l’on part de l’année 2018 où les smartphones ont été pris en compte pour la première fois, portant à 15,4 millions le nombre d’« internautes pirates », cela représente un recul de 59 % en cinq ans (voir graphique ci-dessous). Mais le piratage en ligne (streaming et téléchargement) n’est pas mort pour autant. « L’efficacité est “relative” si l’on regarde la courbe du piratage », relève le délégué général de l’Alpa, d’autant que « nos statistiques ne prennent pas en compte les blocages des services IPTV que nous opérons depuis 2020 ».

@

Charles de Laubier

« Entre la fin de nos propres analyses que nous sommes en train de mener sur l’audience de Telegram – en distinguant la partie messagerie, qui ne concerne pas le DSA, et la partie groupes ouverts fonctionnant comme un réseau social, relevant du DSA – et le temps qu’il faudra pour s’assurer juridiquement de nos conclusions et de les notifier à l’entreprise Telegram, cela prendra au moins un mois », indique à Edition Multimédi@, Thomas Regnier, porteparole de la Commission européenne. « Nous avons des doutes sur les 41 millions d’utilisateurs en Europe que la plateforme a déclarés en février dernier », ajoute le porte-parole.

« Entre la fin de nos propres analyses que nous sommes en train de mener sur l’audience de Telegram – en distinguant la partie messagerie, qui ne concerne pas le DSA, et la partie groupes ouverts fonctionnant comme un réseau social, relevant du DSA – et le temps qu’il faudra pour s’assurer juridiquement de nos conclusions et de les notifier à l’entreprise Telegram, cela prendra au moins un mois », indique à Edition Multimédi@, Thomas Regnier, porteparole de la Commission européenne. « Nous avons des doutes sur les 41 millions d’utilisateurs en Europe que la plateforme a déclarés en février dernier », ajoute le porte-parole.

Les « cyberlockers » ont le vent en poupe et jouent au chat et à la souris avec les ayants droits, les régulateurs et les juges. En France, rien qu’en janvier 2024, ce ne sont pas moins cinq d’entre eux – Turbobit, Rapidgator, Streamtape, Upstream et Nitroflare – qui ont été bloqués par décision de justice. En un an, près d’une quinzaine de ces sites d’hébergement générateurs de liens web uniques ou multiples – des URL (Uniform Resource Locator) pour permettre de télécharger des fichiers de contenus et de les partager – ont été bloqués, sur décision du juge, par les Orange, SFR, Bouygues ou Free.

Les 25 membres de l’Alpa en lutte

Outre les cinq cyberlockers épinglés en janvier, il en a aussi été ainsi de Doodstream, Mixdrop, Vidoza et Netu par jugement de juin 2023, de Uptobox en mai 2023 (

Les « cyberlockers » ont le vent en poupe et jouent au chat et à la souris avec les ayants droits, les régulateurs et les juges. En France, rien qu’en janvier 2024, ce ne sont pas moins cinq d’entre eux – Turbobit, Rapidgator, Streamtape, Upstream et Nitroflare – qui ont été bloqués par décision de justice. En un an, près d’une quinzaine de ces sites d’hébergement générateurs de liens web uniques ou multiples – des URL (Uniform Resource Locator) pour permettre de télécharger des fichiers de contenus et de les partager – ont été bloqués, sur décision du juge, par les Orange, SFR, Bouygues ou Free.

Les 25 membres de l’Alpa en lutte

Outre les cinq cyberlockers épinglés en janvier, il en a aussi été ainsi de Doodstream, Mixdrop, Vidoza et Netu par jugement de juin 2023, de Uptobox en mai 2023 ( Le CNC pourra bientôt saisir l’Arcom

Grand argentier du cinéma, de l’audiovisuel et du multimédia (dont la création numérique sur Internet, jeu vidéo, réalité virtuelle et métavers), le CNC pourrait voir ses pouvoirs étendus aux sites miroirs par la proposition de loi « visant à conforter la filière cinématographique ». Ce texte législatif, qui a été adopté en première lecture au Sénat le 14 février dernier et est actuellement entre les mains de la commission des affaires culturelles et de l’éducation de l’Assemblée nationale (

Le CNC pourra bientôt saisir l’Arcom

Grand argentier du cinéma, de l’audiovisuel et du multimédia (dont la création numérique sur Internet, jeu vidéo, réalité virtuelle et métavers), le CNC pourrait voir ses pouvoirs étendus aux sites miroirs par la proposition de loi « visant à conforter la filière cinématographique ». Ce texte législatif, qui a été adopté en première lecture au Sénat le 14 février dernier et est actuellement entre les mains de la commission des affaires culturelles et de l’éducation de l’Assemblée nationale (

Il n’y aura pas de super-régulateur européen d’Internet, mais c’est tout comme. Avec le règlement sur les services numériques, le DSA (Digital Services Act), qui entre pleinement en application le 17 février (

Il n’y aura pas de super-régulateur européen d’Internet, mais c’est tout comme. Avec le règlement sur les services numériques, le DSA (Digital Services Act), qui entre pleinement en application le 17 février (