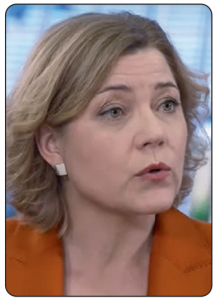

Le projet de règlement européen sur les réseaux numériques – le Digital Networks Act (DNA) qu’avait initié en 2023 Thierry Breton lorsqu’il était commissaire européen au marché intérieur – est à l’agenda 2025 de la nouvelle Commission européenne. Henna Virkkunen reprend le flambeau.

Le programme de travail de la Commission européenne pour 2025, présenté à Bruxelles le 11 février dernier, notamment au Parlement européen en vue de légiférer, est on ne peut plus clair : « La condition préalable la plus importante pour une économie numérique prospère est une infrastructure numérique fiable et de grande capacité. Par conséquent, le règlement sur les réseaux numériques créera des possibilités d’exploitation et de prestation de services transfrontalières, renforcera la compétitivité de l’industrie et améliorera la coordination du spectre [des fréquences, ndlr] ».

Le programme de travail de la Commission européenne pour 2025, présenté à Bruxelles le 11 février dernier, notamment au Parlement européen en vue de légiférer, est on ne peut plus clair : « La condition préalable la plus importante pour une économie numérique prospère est une infrastructure numérique fiable et de grande capacité. Par conséquent, le règlement sur les réseaux numériques créera des possibilités d’exploitation et de prestation de services transfrontalières, renforcera la compétitivité de l’industrie et améliorera la coordination du spectre [des fréquences, ndlr] ».

Le DNA sera présenté à partir d’octobre 2025

Si le Digital Networks Act (DNA) n’est ainsi mentionné qu’en sixième page du programme de travail de la Commission européenne pour 2025, adopté le 11 février (1), ce projet de règlement sur les réseaux numériques est bien parmi les priorités de la présidente Ursula von der Leyen, laquelle a entamé son second mandat « 2024-2029 » il y a maintenant trois mois. Dans les annexes de ce programme de travail des commissaires européens pour l’année en cours, ce futur texte législatif controversé apparaît bien dans la liste de travail mais pas sur fond bleu, couleur choisie par Bruxelles pour désigner justement les sujets contribuant aux nouveaux objectifs de « simplification » et de « réduction de la bureaucratie inutile » que recherche désormais Bruxelles pour « réduire les charges administratives et simplifier les règles de l’UE ». Dans ces annexes (2), l’on apprend que – à défaut d’être donc « simplificatrice » – cette future loi

(suite)

Au plus tard le 21 décembre 2025, et tous les cinq ans par la suite, la Commission européenne est tenue de réexamine le fonctionnement de la directive de 2018 établissant le code des communications électroniques européen (CCEE). De même, d’ici cette même échéance, et tous les cinq ans là aussi, elle doit aussi réexaminer la portée du service universel, en vue de proposer la modification ou la redéfinition du champ d’application.

Au plus tard le 21 décembre 2025, et tous les cinq ans par la suite, la Commission européenne est tenue de réexamine le fonctionnement de la directive de 2018 établissant le code des communications électroniques européen (CCEE). De même, d’ici cette même échéance, et tous les cinq ans là aussi, elle doit aussi réexaminer la portée du service universel, en vue de proposer la modification ou la redéfinition du champ d’application. C’est le grand paradoxe de Believe : le streaming musical a explosé sur les plateformes numériques, mais pas le cours de Bourse de la petite major de la musique enregistrée. Au niveau mondial, d’après la Fédération internationale de l’industrie phonographique (IFPI), la musique en streaming a généré l’an dernier un total de 19,3 milliards de dollars de revenus – soit une hausse de 10,2 % sur un an. Tandis que le chiffre d’affaires de Believe a grimpé de 15,7 % pour atteindre 880,3 millions d’euros (avec une perte nette ramenée à 2,7 millions au lieu de 25 millions l’année précédente). Pourtant, les investisseurs boursiers ne semblent pas croire en la société Believe qui a été introduite mi-2021 à la Bourse de Paris (Euronext) au prix de 19,50 par action.

C’est le grand paradoxe de Believe : le streaming musical a explosé sur les plateformes numériques, mais pas le cours de Bourse de la petite major de la musique enregistrée. Au niveau mondial, d’après la Fédération internationale de l’industrie phonographique (IFPI), la musique en streaming a généré l’an dernier un total de 19,3 milliards de dollars de revenus – soit une hausse de 10,2 % sur un an. Tandis que le chiffre d’affaires de Believe a grimpé de 15,7 % pour atteindre 880,3 millions d’euros (avec une perte nette ramenée à 2,7 millions au lieu de 25 millions l’année précédente). Pourtant, les investisseurs boursiers ne semblent pas croire en la société Believe qui a été introduite mi-2021 à la Bourse de Paris (Euronext) au prix de 19,50 par action.