Le potentiel « champion européen » de l’IA générative, Mistral AI, a beau être valorisé près de 6 milliards d’euros depuis l’an dernier, son chiffre d’affaires 2024 est 200 fois inférieur. Pour mettre les bouchées doubles, la licorne française peut compter sur le chef de l’Etat Emmanuel Macron qui joue les VRP.

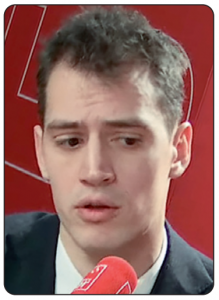

La licorne française Mistral AI, aux ambitions aussi grandes que sa valorisation de 5,8 milliards d’euros – atteinte il y a un an maintenant, à la faveur de sa dernière levée de fonds de 600 millions d’euros bouclée en juin 2024 –, a un besoin urgent de financements supplémentaires. Son PDG cofondateur Arthur Mensch (photo) l’avait confirmé à l’agence Bloomberg en février, notamment pour financer un centre de données qu’il prévoit de créer en France. « Bien sûr, en tant que start-up, on vous demande aussi de lever plus de fonds. C’est certainement un sujet qui nous préoccupe », avait-il confié (1). Le jeune patron (32 ans) avait annoncé ce projet de data center au journal de 20h de TF1, le 9 février (2). De plusieurs milliers de mètres carrés, il sera construit dans l’Essonne (département du sud de Paris), sur le plateau de Saclay, pour un investissement de « plusieurs milliards d’euros ». Si le calendrier de construction et d’ouverture reste à préciser, ce centre de données va permettre à « la pépite française » d’entraîner sur le sol français – au nom de la « souveraineté numérique » de la France – ses grands modèles de langage pour ses IA génératives. Mais cela suppose donc une prochaine levée de fonds pour Mistral AI, qui n’a généré en 2024 que 30 millions d’euros de chiffre d’affaires, si l’on en croit le site Sifted.eu du Financial Times spécialisé dans les start-up (3). C’est à des années-lumière des 10 milliards de dollars annualisés que l’américain OpenAI (dont ChatGPT) a atteint en juin 2025 (4).

La licorne française Mistral AI, aux ambitions aussi grandes que sa valorisation de 5,8 milliards d’euros – atteinte il y a un an maintenant, à la faveur de sa dernière levée de fonds de 600 millions d’euros bouclée en juin 2024 –, a un besoin urgent de financements supplémentaires. Son PDG cofondateur Arthur Mensch (photo) l’avait confirmé à l’agence Bloomberg en février, notamment pour financer un centre de données qu’il prévoit de créer en France. « Bien sûr, en tant que start-up, on vous demande aussi de lever plus de fonds. C’est certainement un sujet qui nous préoccupe », avait-il confié (1). Le jeune patron (32 ans) avait annoncé ce projet de data center au journal de 20h de TF1, le 9 février (2). De plusieurs milliers de mètres carrés, il sera construit dans l’Essonne (département du sud de Paris), sur le plateau de Saclay, pour un investissement de « plusieurs milliards d’euros ». Si le calendrier de construction et d’ouverture reste à préciser, ce centre de données va permettre à « la pépite française » d’entraîner sur le sol français – au nom de la « souveraineté numérique » de la France – ses grands modèles de langage pour ses IA génératives. Mais cela suppose donc une prochaine levée de fonds pour Mistral AI, qui n’a généré en 2024 que 30 millions d’euros de chiffre d’affaires, si l’on en croit le site Sifted.eu du Financial Times spécialisé dans les start-up (3). C’est à des années-lumière des 10 milliards de dollars annualisés que l’américain OpenAI (dont ChatGPT) a atteint en juin 2025 (4).

Prochaine levée de fonds indispensable

Comme la licorne n’est, par définition, pas cotée en Bourse, elle ne publie pas ses comptes et ne divulgue pas non plus ses résultats financiers. Contactée par Edition Multimédi@, la direction de Mistral AI n’a pas souhaité nous indiquer ni ses revenus ni ses prévisions. Le 7 mai dernier, à l’occasion du lancement de « Le Chat Enterprise » (assistant conversationnel dont la version grand public « Le Chat » a été lancée en février), Arthur Mensch s’est voulu rassurant quant à la (suite)

C’est un sujet à donner des sueurs froides aux titulaires de droit d’auteur ! Avec l’entrée en vigueur du règlement européen du 13 juin 2024 sur l’intelligence artificielle (IA) – l’AI Act (

C’est un sujet à donner des sueurs froides aux titulaires de droit d’auteur ! Avec l’entrée en vigueur du règlement européen du 13 juin 2024 sur l’intelligence artificielle (IA) – l’AI Act ( Les ChatGPT, Claude, Perplexity, Meta Ai et bien d’autres intelligences génératives vont devoir mettre la main au portefeuille pour rémunérer équitablement les auteurs et les créateurs lorsqu’elles utilisent leurs œuvres. Trois organismes ont chacun publié leur rapport dans le courant du mois de mai 2025 : l’US Copyright Office (USCO) aux Etats-Unis le 9 mai, l’Office de l’Union européenne pour la propriété intellectuelle (EUIPO) en Europe le 12 mai et le Conseil supérieur de la propriété littéraire et artistique (CSPLA) en France le 16 mai.

Les ChatGPT, Claude, Perplexity, Meta Ai et bien d’autres intelligences génératives vont devoir mettre la main au portefeuille pour rémunérer équitablement les auteurs et les créateurs lorsqu’elles utilisent leurs œuvres. Trois organismes ont chacun publié leur rapport dans le courant du mois de mai 2025 : l’US Copyright Office (USCO) aux Etats-Unis le 9 mai, l’Office de l’Union européenne pour la propriété intellectuelle (EUIPO) en Europe le 12 mai et le Conseil supérieur de la propriété littéraire et artistique (CSPLA) en France le 16 mai. « En nous concentrant sur l’activité dédiée aux plateformes de jeux vidéo, nous exprimons l’attrait et la valeur de la Nintendo Switch – associée à des offres de jeux uniques tels que les titres Super Mario – comme une expérience qui peut être appréciée à tout moment, n’importe où et avec n’importe qui », a réaffirmé celui qui est PDG de la firme de Kyoto depuis le 28 juin 2018, après y être entré au milieu des années 1990 en intégrant l’incontournable case « Switch ». Shuntaro Furukawa (photo) s’est adressé ainsi aux actionnaires et aux investisseurs le 8 mai dernier, à l’occasion de la présentation des résultats annuels de la multinationale japonaise (clos le 31 mars), dont la 85e assemblée générale des actionnaires se tiendra le 27 juin 2025. Or le groupe Nintendo est plus que jamais dépendant de sa plateforme Switch puisqu’elle génère – matériel, logiciels (Nintendo Switch Online compris) et accessoires – 90,2 % du chiffre d’affaires total de l’exercice annuel qui s’est terminé le 31 mars 2025. Le problème pour la kabushiki gaisha (société par actions japonaise) est que lorsque les ventes de la Switch baissent, comme ce fut le cas au cours des deux dernières années, cela a un impact direct sur son chiffre d’affaires global : celui-ci a chuté de – 30 % sur un an, à 1.165 milliards de yens (7,19 milliards d’euros au taux de change du 31 mars).

« En nous concentrant sur l’activité dédiée aux plateformes de jeux vidéo, nous exprimons l’attrait et la valeur de la Nintendo Switch – associée à des offres de jeux uniques tels que les titres Super Mario – comme une expérience qui peut être appréciée à tout moment, n’importe où et avec n’importe qui », a réaffirmé celui qui est PDG de la firme de Kyoto depuis le 28 juin 2018, après y être entré au milieu des années 1990 en intégrant l’incontournable case « Switch ». Shuntaro Furukawa (photo) s’est adressé ainsi aux actionnaires et aux investisseurs le 8 mai dernier, à l’occasion de la présentation des résultats annuels de la multinationale japonaise (clos le 31 mars), dont la 85e assemblée générale des actionnaires se tiendra le 27 juin 2025. Or le groupe Nintendo est plus que jamais dépendant de sa plateforme Switch puisqu’elle génère – matériel, logiciels (Nintendo Switch Online compris) et accessoires – 90,2 % du chiffre d’affaires total de l’exercice annuel qui s’est terminé le 31 mars 2025. Le problème pour la kabushiki gaisha (société par actions japonaise) est que lorsque les ventes de la Switch baissent, comme ce fut le cas au cours des deux dernières années, cela a un impact direct sur son chiffre d’affaires global : celui-ci a chuté de – 30 % sur un an, à 1.165 milliards de yens (7,19 milliards d’euros au taux de change du 31 mars).