« Nous sommes les réseaux sociaux » est un essai de Serge Abiteboul, un des sept membres du collège de l’Arcep, et de Jean Cattan, secrétaire général du Conseil national du numérique (CNNum). Ils prônent « une véritable régulation-supervision » des réseaux sociaux « opérée par la société ».

Paru le 7 septembre 2022 aux éditions Odile Jacob, le livre de Serge Abiteboul (photo de gauche) et de Jean Cattan (photo de droite) – intitulé « Nous sommes les réseaux sociaux » – propose un nouveau modèle de régulation des Facebook, Twitter et autres TikTok. « Entre la censure excessive et le laisser-faire, une autre voie est possible, plus démocratique, plus participative », assurent-ils. Au bout de 250 pages (1), ils lancent un appel : « Une véritable régulation supervision opérée par la société nous paraît souhaitable. Une telle initiative permettrait d’animer un débat citoyen pour choisir la modération que nous souhaitons ».

Paru le 7 septembre 2022 aux éditions Odile Jacob, le livre de Serge Abiteboul (photo de gauche) et de Jean Cattan (photo de droite) – intitulé « Nous sommes les réseaux sociaux » – propose un nouveau modèle de régulation des Facebook, Twitter et autres TikTok. « Entre la censure excessive et le laisser-faire, une autre voie est possible, plus démocratique, plus participative », assurent-ils. Au bout de 250 pages (1), ils lancent un appel : « Une véritable régulation supervision opérée par la société nous paraît souhaitable. Une telle initiative permettrait d’animer un débat citoyen pour choisir la modération que nous souhaitons ».

Les risques d’un Etat « modérateur »

« Oui à une régulation fondée sur un débat citoyen, une régulation par la société », prônent Serge Abiteboul et Jean Cattan, respectivement membre du collège de l’Arcep et secrétaire général du Conseil national du numérique (CNNum). Cette régulation-supervision par la société gagnerait ainsi «sa légitimité à imposer aux réseaux sociaux une modération raisonnable qui donnerait à tous les moyens de s’exprimer dans le respect de chacun ». Et de prendre en exemple Wikipedia : l’encyclopédie en ligne montre qu’« il est possible d’exercer collectivement une forme d’intelligence de modération qui fonctionne », en tirant parti des « dynamiques collectives vertueuses ». Jimmy Wales, le fondateur de Wikipedia (2), a d’ailleurs lancé en 2019 un réseau social qu’il décrit comme « non-toxique » : WT.Social (3). L’intelligence collective des internautes en guise de régulation des réseaux sociaux serait elle la solution ? L’autorégulation par les plateformes elles-mêmes montre ses limites ; la censure stricte des contenus porte atteinte à la liberté d’expression et à la liberté d’informer ; la modération rigoriste freine l’émergence de nouvelles idées. Par conséquent, une régulation-supervision par la société semble la bonne voie : « Nous sommes les réseaux sociaux », titrent justement les auteurs de cet essai.

Mais cette régulation-supervision doit-elle se faire par l’intelligence collective de la société civile elle-même et, donc, sans l’intervention d’une autorité de régulation relevant d’un Etat, ou bien faudrait-il que cette régulation-supervision soit encadrée par les pouvoirs publics (gouvernement, régulateur, législateur, justice, …) ? Serge Abiteboul et Jean Cattan rejettent d’emblée – et c’est heureux – la voie d’une régulation tout-étatique : « Une régulation-supervision qui consacrerait un tête-à-tête entre l’Etat et le réseau social ne serait pas (…) à l’abris d’un rejet de la société ». Ils prônent donc « une véritable contribution (…) de la société à la modération [qui] serait non seulement gage d’une plus grande acceptabilité mais surtout d’une plus grande qualité ». Pour autant, les deux auteurs écartent implicitement la voie – pourtant possible – d’une régulation-supervision par la seule société civile, à la manière de Wikipedia dont ils parlent – et où ce sont les 103,9 millions d’individus contributeurs et les 3.762 administrateurs, au 20 septembre 2022 (4), qui ont voix au chapitre et non les régulateurs ni les gouvernements.

Au lieu de cela, le membre de l’Arcep et le secrétaire général du CNNum retiennent plutôt une approche à la manière de la « Mission Facebook ». A savoir : « Que les réseaux sociaux entrent dans un dialogue politique informé avec toutes les parties prenantes [gouvernement, législateur, justice, entreprises, société civile, …], collectivement ». Cette idée d’une « corégulation entre les plateformes et les autorités publiques » avait été évoquée par Mark Zuckerberg, PDG cofondateur de Facebook, et Emmanuel Macron, le président de la France, lors de leur rencontre en 2018 (5). Le rapport de la « Mission Facebook », remis par Macron à Zuckerberg le 17 mai 2019 à l’Elysée (6), a inspiré l’Europe sur certains points du DSA (Digital Services Act) : comme la « supervision » des moyens mis en œuvre par les plus grandes plateformes numériques – celles présentant un « risque systémique » – pour modérer les contenus nocifs. Mais le DSA, lui, n’associe pas directement la société civile et les internautes.

Europe : l’acte manqué du DSA

La « régulation-supervision » reste entre les mains de la Commission européenne (sur les très grandes plateformes), le nouveau Comité européen des services numériques (sur les services intermédiaires) et les régulateurs nationaux (en fonction du pays d’origine). La société civile, elle, reste absente de cette régulation-supervision des réseaux sociaux. « Un tel cadre [associant la société civile] pourrait enrichir le DSA [et] s’appliquer aussi au DMA [Digital Markets Act, ndlr], permettant ainsi à toute la société de participer à l’élaboration des objectifs de régulations », concluent les auteurs. En France, le Conseil d’Etat vient de recommander d’« armer la puissance publique dans son rôle de régulateur » (7) des réseaux sociaux… @

Charles de Laubier

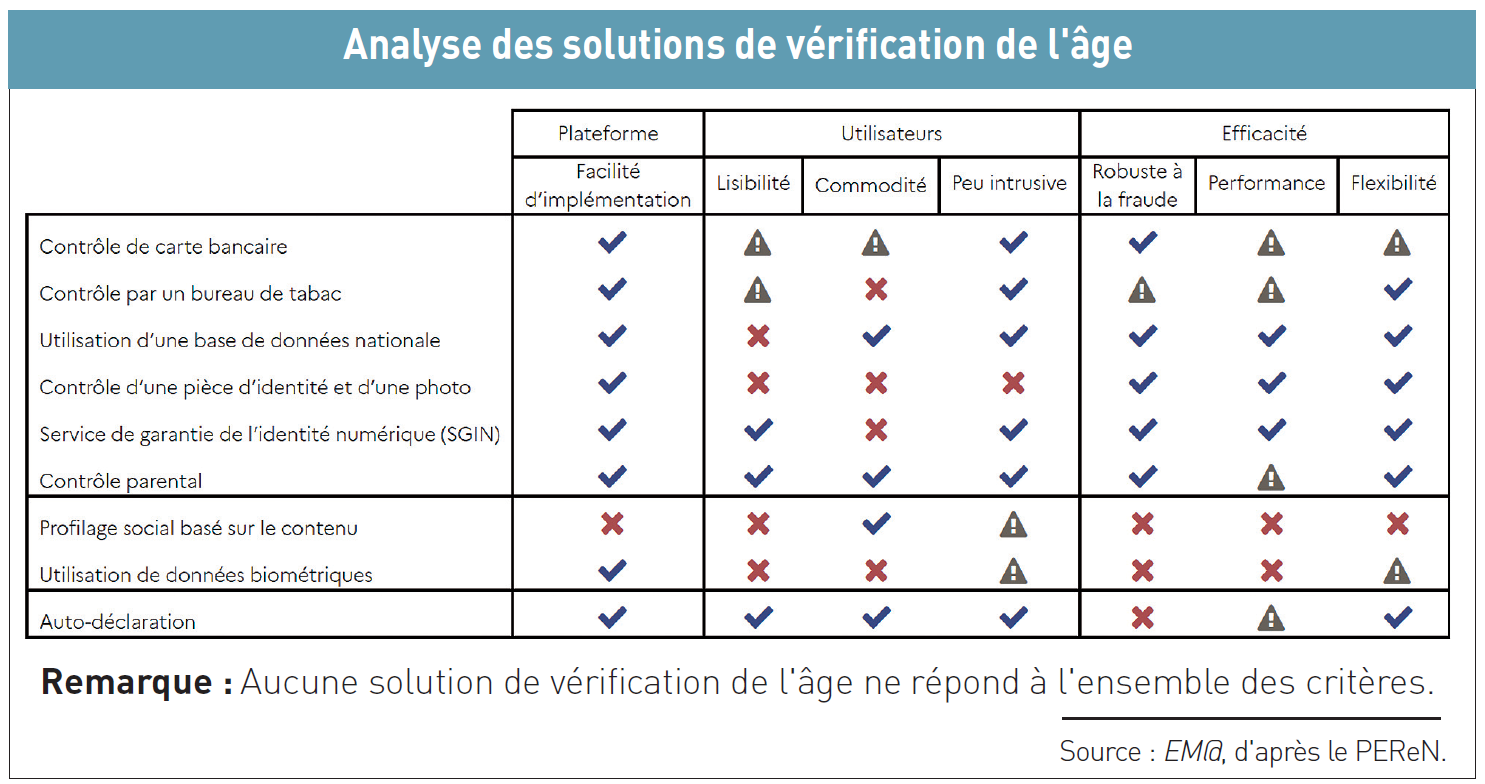

Cela fait un an que la Commission nationale de l’informatique et des libertés (Cnil) a publié – le 9 juin 2021 – huit recommandations pour « renforcer la protection des mineurs en ligne » (

Cela fait un an que la Commission nationale de l’informatique et des libertés (Cnil) a publié – le 9 juin 2021 – huit recommandations pour « renforcer la protection des mineurs en ligne » (

« Nous apprécions les efforts déployés pour créer un marché unique numérique européen plus efficace, clarifier les responsabilités de chacun et protéger les droits en ligne », a déclaré Victoria de Posson (photo de gauche), directrice des affaires publiques de la CCIA Europe, la représentation à Bruxelles de l’association américaine du même sigle, dont sont notamment membres les géants du Net, mais pas Microsoft (

« Nous apprécions les efforts déployés pour créer un marché unique numérique européen plus efficace, clarifier les responsabilités de chacun et protéger les droits en ligne », a déclaré Victoria de Posson (photo de gauche), directrice des affaires publiques de la CCIA Europe, la représentation à Bruxelles de l’association américaine du même sigle, dont sont notamment membres les géants du Net, mais pas Microsoft ( L’issue des tractations et des lobbyings autour des deux propositions de règlement DSA (Digital Services Act) et DMA (Digital Markets Act) va maintenant se jouer entre l’actuelle présidence slovène de l’Union européenne (jusqu’au 31 décembre) et la prochaine présidence française (du 1er janvier au 30 juin 2022). Une réunion des Etats membres des Vingt-sept est prévue le 25 novembre – « Rue de la Loi », dans les locaux de la Commission européenne à Bruxe l le s – s o u s le thème de « Compétitivité » dans le marché intérieur et l’industrie.

L’issue des tractations et des lobbyings autour des deux propositions de règlement DSA (Digital Services Act) et DMA (Digital Markets Act) va maintenant se jouer entre l’actuelle présidence slovène de l’Union européenne (jusqu’au 31 décembre) et la prochaine présidence française (du 1er janvier au 30 juin 2022). Une réunion des Etats membres des Vingt-sept est prévue le 25 novembre – « Rue de la Loi », dans les locaux de la Commission européenne à Bruxe l le s – s o u s le thème de « Compétitivité » dans le marché intérieur et l’industrie.