L’équipementier télécoms Ericsson a publié en octobre une étude voulant démontrer que « la 5G ouvre la voie au métavers ». Une étude d’Analysis Group, financée par Meta et parue en mai dernier, chiffre à 3.000 milliards de dollars l’apport des métavers au PIB Mondial d’ici 2031. Nouvel Eldorado ?

Les métavers font couler beaucoup d’encre, mais ils tardent à faire la preuve de leurs réelles perspectives économiques. Contribuerontils à hauteur de 3.000 milliards de dollars au produit intérieur brut (PIB) mondial d’ici le début de la prochaine décennie, comme le calcule Analysis Group dans son étude publiée au printemps dernier et financée par le groupe Meta (ex-Facebook) ? L’agence financière Bloomberg, elle, table sur un marché mondial du métavers de 800 milliards de dollars d’ici 2025. Entre les équipements (casques de réalité virtuelle en tête) et les dépenses dans ces mondes virtuels (dont la publicité), les perspectives sont dignes d’un « Eldorado 3.0 ».

La 5G, un catalyseur de métavers

De son côté, le suédois Ericsson a publié en octobre une étude intitulée « 5G : The Next Wave », présentée comme « la plus grande étude sur la 5G menée à ce jour auprès des consommateurs » (49.100 personnes interrogées dans 37 pays, représentatives de 430 millions d’utilisateurs de la 5G). Il en ressort que « l’adoption de la 5G ouvre la voie au métavers » et que « la transition des services immersifs vers des expériences métavers est en cours », les abonnés à la 5G faisant déjà leurs premiers pas dans ces mondes virtuels.

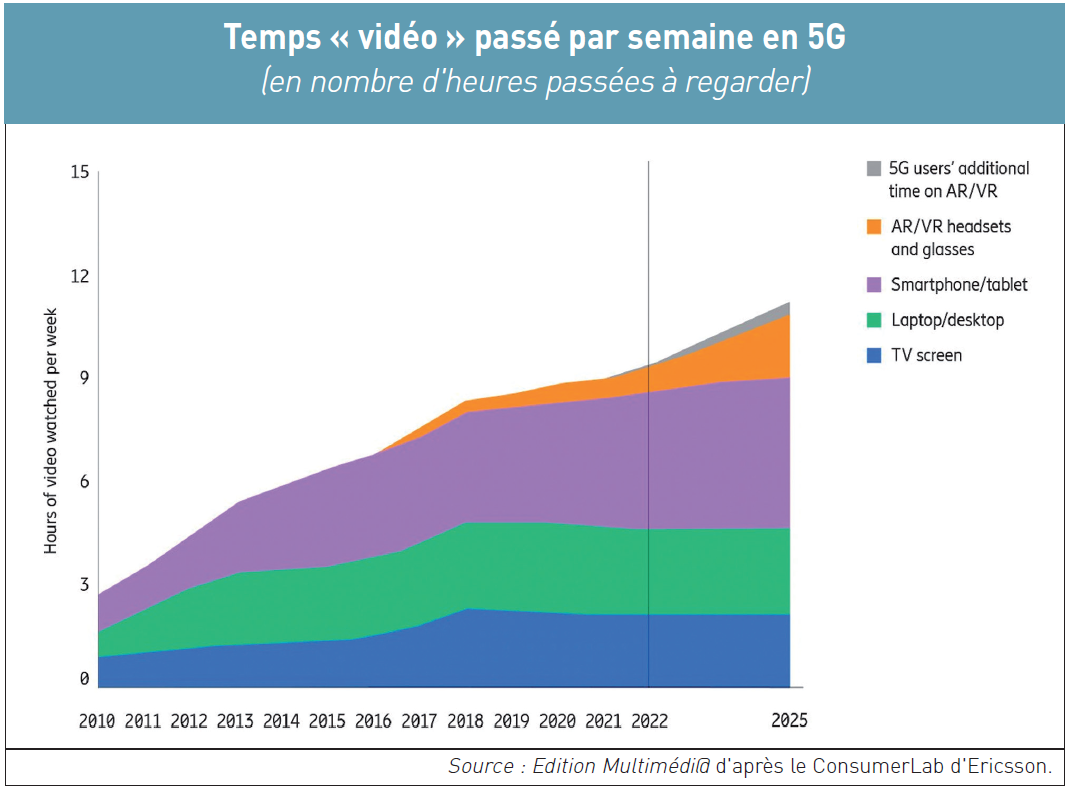

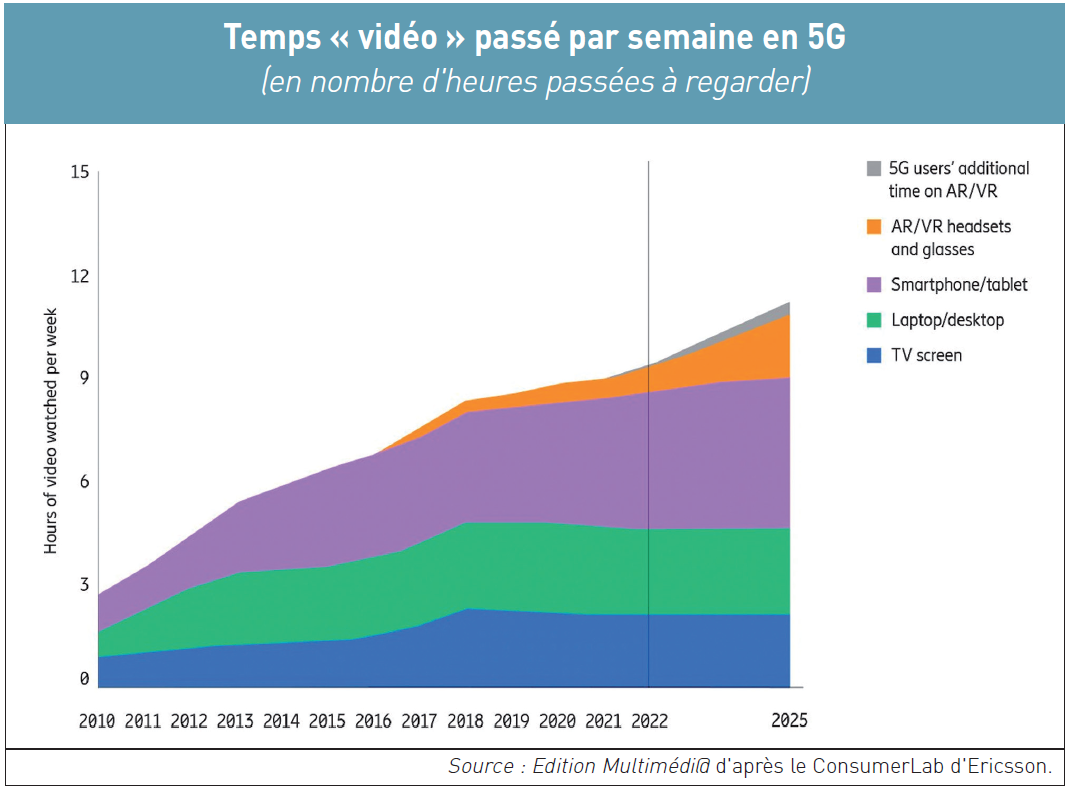

L’équipementier télécoms suédois, qui fournit bon nombre d’opérateurs de réseaux en infrastructure mobile (3G, 4G, 5G, …), constate que les utilisateurs de la 5G consacrent aujourd’hui en moyenne une heure de plus par semaine que les utilisateurs de la 4G à des activités liées aux métavers. Ils y pratiquent le jeu en ligne, la socialisation, le shopping, la participation à des concerts ou à des événements virtuels, ainsi que l’utilisation d’applications de réalité augmentée. « Les utilisateurs de la 5G pensent que d’ici 2025, 2 heures supplémentaires de contenu vidéo seront consommées chaque semaine sur les appareils mobiles, dont 1,5 heure sur les lunettes de réalité mixte plutôt que sur les smartphones », souligne le ConsumerLab d’Ericsson, dirigé par Jasmeet Sethi (photo de gauche), qui a réalisé ce sondage planétaire. Quant aux utilisateurs de la 4G, ils prévoient d’accroître leur « engagement », autrement dit les interactions, avec le métavers une fois qu’ils se seront abonnés à la 5G : 41 % indiquent qu’ils commenceront à utiliser ou à accroître leur utilisation de la réalité augmentée. « Globalement, six utilisateurs de smartphones sur dix pensent que la 5G est essentielle à la réalisation du métavers. La vitesse plus élevée, la fiabilité et le faible temps de latence de la 5G permettent aux utilisateurs de faire l’expérience de la XR [eXtended Reality] et d’autres activités », relève l’étude d’Ericsson. En France notamment, « 30 % des utilisateurs français déclarent qu’ils commenceront ou augmenteront l’utilisation d’applications de réalité augmentée dans le monde réel après avoir souscrit à la 5G ».

Autres enseignements de l’enquête mondiale : les utilisateurs de la 5G passent en moyenne 1 heure de plus par semaine dans les métavers que les utilisateurs de la 4G. Ces mondes virtuels existent dans les jeux en ligne et mobiles comme ceux de Roblox, Fortnite ou des jeux de réalité augmentée comme ceux de Niantic, mais aussi sur les plateformes de réalité virtuelle sociale ou les plateformes qui permettent aux utilisateurs de créer des expériences, de se socialiser, de vendre et d’acheter, de se divertir dans des environnements en 3D tels que Zepeto ou Ifland des groupes sud-coréens respectivement Naver et SK Telecom. « Les technologies telles que la VR [Virtual Reality], la AR [Augmented Reality], l’AI [Artificial Intelligence], la 5G, la blockchain, les NFT et bien d’autres sont toutes situées dans le monde des métavers et représentent une convergence et une mise à l’échelle de ces différents produits, services et visions en un seul ou plusieurs mondes en ligne interopérables », explique le ConsumerLab (1).

Les entreprises vont se « métaverser »

Les consommateurs s’attendent à ce que la 5G continue de pousser l’utilisation améliorée des vidéos au-delà du smartphone, à savoir sur les casques de réalité virtuelle et sur les lunettes connectées : en 2025, au moins 2 heures de contenu vidéo seront consommées chaque semaine sur les appareils mobiles, dont 1,5 heure sur les lunettes AR/VR (voir graphique page suivante). De son côté, le cabinet d’étude américain Gartner est lui aussi confiant en l’avenir du métavers : d’ici 2026, un quart des gens dans le monde passeront au moins 1 heure dans le métavers pour le travail, le shopping, l’éducation, l’interaction sociale et/ou le divertissement. La moitié des utilisateurs de la 5G qui utilisent déjà des services de réalité virtuelle (VR), constate Gartner, pensent que les applications de réalité augmentée (AR) passeront des smartphones aux casques XR d’ici deux ans, alors qu’un tiers seulement des utilisateurs de la 4G le pensent. « Les fournisseurs créent déjà des moyens pour les utilisateurs de reproduire leur vie dans le monde numérique. Qu’il s’agisse d’assister à des classes virtuelles, d’acheter des terrains numériques ou de construire des maisons virtuelles, ces activités se déroulent actuellement dans des environnements distincts. Ils finiront par se dérouler dans un environnement unique – le métavers – avec de multiples destinations », prévoit Marty Resnick (photo de droite), vice-président chez Gartner. Selon lui, comme aucun fournisseur unique possédera le métavers, il faut s’attendre à ce qu’il ait une économie virtuelle activée par les monnaies numériques (les cryptos) et les jetons non-fongibles (NFT). Cela sera aussi valable dans le monde des entreprises, qui pourront se réorganiser avec des espaces de travail immersifs dans des bureaux virtuels, d’autant que les deux années de confinements ou de restrictions sanitaires ont popularisé les visioconférences, les webinars ou encore les téléconsultations.

Lever les doutes persistants

Les entreprises n’auront pas besoin de créer leur propre infrastructure pour le faire parce que le métavers fournira le cadre. « D’ici 2026, 30 % des organisations dans le monde auront des produits et des services prêts pour le métavers », projette Marty Resnick (2). De quoi conforter Mark Zuckerberg, PDG cofondateur de Facebook – géant du Net devenu il y a un an Meta pour mieux embrasser la cause du métavers. Dans son étude d’une cinquantaine de pages (3) commanditée par Meta justement, le cabinet d’études américain Analysis Group évalue l’impact positif du métavers dans son ensemble à 2,8 % du PIB d’ici 2031. La région du monde qui en profitera le plus sera l’Asie-Pacifique (2,3 % du PIB), suivie des Etats-Unis (2,3 %), de l’Europe (1,7 %) et du Moyen-Orient/Afrique du Nord/Turquie (6,2 %). D’autres études tentent aussi de chiffer le futur du métavers : Grand View Research (4) prévoit près de 679 milliards de dollars en 2030 ; McKinsey (5) table sur 5.000 milliards de dollars en 2030 ; Fortune Business Insights (6) avance plus de 500 milliards de dollars en 2029.

Mais les freins aux déploiements des métavers existent, tels que leur impact carbone sur l’environnement (7). Quant aux Etats, ils ne veulent pas y perdre leur « souveraineté culturelle et technologique ». C’est du moins la volonté du gouvernement français qui a publié le 24 octobre un rapport « exploratoire » sur les métavers avec dix propositions (8), dont l’une est la création d’« un institut de recherche et coordination, sur le modèle de l’Ircam » (9).

Il y a aussi et surtout l’attentisme de la plupart des 4,5 milliards d’utilisateurs de réseaux sociaux dans le monde, notamment ceux de la jeune génération « TikTok », qui… attendent de voir. Résultat : les métavers d’aujourd’hui semblent déserts, au grand dam de « Zuck » et de son directeur du métavers, Vishal Shah (photo), lequel a envoyé le 20 septembre à ses propres équipes un memo – révélé le 7 octobre par The Verge – leur disant : « Tout le monde dans cette entreprise [Meta] devrait se donner pour mission de tomber amoureux d’Horizon Worlds [le métaversmaison, ndlr]. Vous ne pouvez pas le faire sans l’utiliser. Allez-y ! » (10). Y-a plus qu’à. @

Charles de Laubier

Après ChatGPT que la start-up américaine OpenAI – dirigée par son cofondateur Sam Altman (photo) – a lancé le 30 novembre 2022 (

Après ChatGPT que la start-up américaine OpenAI – dirigée par son cofondateur Sam Altman (photo) – a lancé le 30 novembre 2022 ( Le président ukrainien Volodymyr Zelensky a expliqué l’an dernier dans une vidéo qu’il avait capitulé face aux russes et qu’il appelait les soldats de son pays à déposer les armes (

Le président ukrainien Volodymyr Zelensky a expliqué l’an dernier dans une vidéo qu’il avait capitulé face aux russes et qu’il appelait les soldats de son pays à déposer les armes (