Les patrons de Facebook, Google et Twitter ont été auditionnés le 25 mars au Congrès des Etats-Unis sur « le rôle des médias sociaux dans la promotion de l’extrémisme et de la désinformation » (1). Aucun ne s’oppose à une réforme de la responsabilité des plateformes. L’Europe, elle, a pris de l’avance.

Par Olivia Roche, avocate, et Prudence Cadio, avocate associée, cabinet LPA-CGR avocats

L’utilisation toujours plus massive d’Internet par les internautes a progressivement conduit les plateformes à opérer un filtrage renforcé de leurs contenus. A défaut de contours clairs des règles qui leur sont applicables, les hébergeurs endossent ainsi un nouveau rôle de « premier juge » en établissant des standards pour écarter les éventuels abus liés à l’utilisation de leurs services.

L’utilisation toujours plus massive d’Internet par les internautes a progressivement conduit les plateformes à opérer un filtrage renforcé de leurs contenus. A défaut de contours clairs des règles qui leur sont applicables, les hébergeurs endossent ainsi un nouveau rôle de « premier juge » en établissant des standards pour écarter les éventuels abus liés à l’utilisation de leurs services.

Les plateformes, juges et parties

Aujourd’hui, en Europe, les régimes de responsabilité des acteurs de l’Internet résultent principalement de la directive « E-commerce » de 2000 relative à certains aspects juridiques des services de l’information, et notamment du commerce électronique (2). Cette directive européenne a été transposée en droit français par la loi dite « pour la confiance dans l’économie numérique », ou loi « LCEN » (3). Celle-ci distingue, d’une part, les intermédiaires techniques, fournisseurs d’accès à Internet (FAI) et hébergeur et, d’autre part, les éditeurs de contenus, éditeurs de site web et internautes. Les premiers fournissent un accès au public à des services de communications électroniques et leur permettent de stocker les contenus fournis par les destinataires de ce service, tandis que les seconds utilisent ces services comme outils de communication.

Contrairement aux règles applicables aux éditeurs, la LCEN prévoit que les hébergeurs ne sont pas soumis à « une obligation générale de surveiller les informations qu’ils transmettent ou stockent, ni une obligation générale de rechercher des faits ou des circonstances révélant des activités illicites », sans préjudice « de toute activité de surveillance ciblée et temporaire demandée par l’autorité judiciaire » (4). Ainsi, c’est seulement à partir du moment où un contenu illicite est porté à la connaissance de l’hébergeur, que celui-ci doit « agir promptement pour retirer ces données ou en rendre l’accès impossible » (5) – à défaut sa responsabilité étant susceptible d’être engagée. Dès lors, les hébergeurs endossent une responsabilité très limitée dans la mesure où ils ne sont pas tenus de rechercher les contenus illicites parmi ceux qu’ils hébergent. En effet, de même que les FAI, les hébergeurs doivent simplement collaborer à la lutte contre les contenus illicites. Leur responsabilité est limitée aux seuls cas où ils n’auraient pas retiré – promptement – un contenu stocké qu’ils savent manifestement illicite après avoir reçu une notification signalant ce contenu, cette notification étant soumise à des règles précises pour être valide, telles que prévues par la LCEN.

A l’origine, ce régime de responsabilité limitée a été établi pour éviter la censure par les hébergeurs et afin de préserver la liberté d’expression sur Internet. Néanmoins, aujourd’hui, les réseaux sociaux sont de plus en plus présents dans notre environnement en raison du nombre croissant d’utilisateurs et de la multiplication des contenus postés.

Cette explosion de l’utilisation d’Internet a eu pour conséquence le développement d’abus tels que l’incitation à la haine, la violence ou les propos injurieux (mention de l’origine israélienne du père d’April Benayoum, tweets antisémites envers Miss France 2021, affaire de l’influenceur Marvel Fitness, …), ce qui a été renforcé par la possibilité pour les auteurs de rester anonymes. Dans ces conditions, les hébergeurs ont dû dépasser le rôle qui leur avait été initialement été assigné par la directive européenne « E-commerce » et la loi française LCEN en contrôlant davantage les publications mises en ligne via leurs services. L’exposition quotidienne du nombre de contenus mis en ligne et l’impossibilité, en cas de contenus illicites, de saisir autant de juges, au surplus dans un contexte mondialisé, ont contribué au développement de prises de décisions arbitraires et extrajudiciaires par les plateformes numériques elles-mêmes.

Suppressions et risques de censures

Ces opérateurs privés revêtent ainsi progressivement un rôle de « premier juge » dans la mesure où, comme l’a récemment rappelé en France la Cour d’appel de Versailles, ils doivent « prendre toutes mesures techniques » pour « retirer les données illicites ou en rendre l’accès impossible quelles qu’en soient les conséquences » (6). Pour respecter ces obligations, les hébergeurs sont nécessairement amenés à apprécier, de manière autonome et parfois arbitraire, le caractère illicite ou non des contenus partagés via leurs plateformes. Ces systèmes de restriction des réseaux sociaux sont au cœur d’enjeux importants au regard de la liberté d’expression. Un certain nombre d’éditeurs de contenus ou d’utilisateurs de plateformes en ligne ou de réseaux estiment que ces mécanismes se rapprochent aujourd’hui d’une forme de censure de la part des acteurs du Net qui ont pu procéder à des suppressions de contenus jugées abusives.

Techniques de filtrage à encadrer

A titre d’exemples, il y a eu la suspension en janvier 2021 du compte de la militante féministe Mélusine pendant 12 heures suite à un tweet, ainsi que la fermeture en février 2011 du compte de l’enseignant Frédéric Durant qui avait publié une photo du tableau de Gustave Courbet « L’Origine du monde ». Les demandes de retraits se multipliant le rôle des plateformes évolue, celles-ci devant faire un arbitrage dépassant l’appréciation des contenus « manifestement illicites ». Si la viralité des contenus publiés complique la modération, les hébergeurs développent de nouveaux standards qui leur sont propres et leur permettent un contrôle plus accru.

C’est dans ce contexte, où les pratiques de filtrages sur mesure sont mises en œuvre par les plateformes numériques, avec des méthodes souvent floues et nonharmonisées, que les initiatives légales et réglementaires visant à renforcer les obligations des hébergeurs ont été entreprises. La situation actuelle, mais également la volonté de lutter contre la diffusion de contenus haineux ou injurieux en ligne, ont poussé les législateurs à repenser le régime de responsabilité des acteurs de l’Internet. C’est dans cette perspective que la proposition de loi française dite « Avia » (7), visant à lutter contre les contenus haineux sur Internet, avait été portée afin de modifier les dispositions de l’article 6 la LCEN. L’article 1er de la proposition de loi Avia prévoyait notamment que les hébergeurs et les éditeurs disposaient d’un délai d’une heure pour retirer les contenus à caractère terroriste ou pédopornographique notifiés par l’autorité administrative.

Néanmoins, ces dispositions ont été censurées par le Conseil constitutionnel qui a jugé que le dispositif prévu n’aurait fait « qu’inciter les opérateurs de plateforme en ligne à retirer les contenus qui leur sont signalés, qu’ils soient ou non manifestement illicites » et que ces dispositions « portent donc une atteinte à l’exercice de la liberté d’expression et de communication qui n’est pas nécessaire, adaptée et proportionnée » (8). Dans la continuité de la censure partielle de la proposition de loi Avia, un amendement a été porté en janvier 2021 afin d’introduire, au sein du projet de loi confortant « le respect des principes de la République » (9), un mécanisme de contrôle des contenus illicites publiés sur les plateformes en ligne. L’adoption de ce texte permettrait à la France d’anticiper l’entrée en vigueur du règlement européen « Digital Service Act » (DSA) – en cours d’élaboration au sein du Conseil de l’Union européenne et des instances préparatoires (10) – et de se doter de moyens plus efficaces de lutte contre les contenus illicites en ligne.

Cet amendement de « mise en œuvre des procédures et des moyens humains et technologiques proportionnés » (11) vise à compléter le dispositif prévu par la LCEN en créant de nouvelles obligations substantielles à la charge des plateformes numériques en matière de modération des contenus illicites, de transparence quant aux algorithmes utilisés pour retirer des contenus de manière automatisée, ou encore de procédures de traitement des injonctions des autorités judiciaires ou publiques.

Le contrôle de la mise en œuvre de ces obligations serait confié au Conseil supérieur de l’audiovisuel (CSA), en l’occurrence de la future Autorité de régulation de la communication audiovisuelle et numérique (Arcom) issue de la fusion du CSA et de l’Hadopi, qui pourrait prononcer des mises en demeure, éventuellement suivies d’amendes administratives pouvant atteindre 20 millions d’euros ou 6 % du chiffre d’affaires mondial total de l’exercice précédent de la plateforme mise en cause. Ce nouveau dispositif imposerait aux plateformes de l’Internet une meilleure transparence et coopération avec les autorités mais également de publier des conditions générales d’utilisation claires et transparentes, afin de prévoir l’interdiction de mettre en ligne des contenus illicites. Cette réforme obligerait également ces plateformes numériques à détailler leurs moyens et procédures internes pour détecter, identifier et traiter ces contenus illicites, et à prévoir une procédure de recours interne pour contester les décisions de modération qu’elles auraient prises.

Libertés d’expression et de création

Ces tentatives multiples de réforme du statut des hébergeurs de contenus mis en ligne illustrent le principe suivant : si la possibilité d’exprimer ses opinions sur Internet et la liberté de créer ou de caricaturer doivent être protégées, cela doit néces-sairement être concilié avec la sauvegarde de l’ordre public. Compte tenu de ce double objectif, le cadre juridique pertinent est délicat à définir pour protéger la liberté d’expression tout en poursuivant la lutte contre la diffusion massive sur Internet de contenus illicites. @

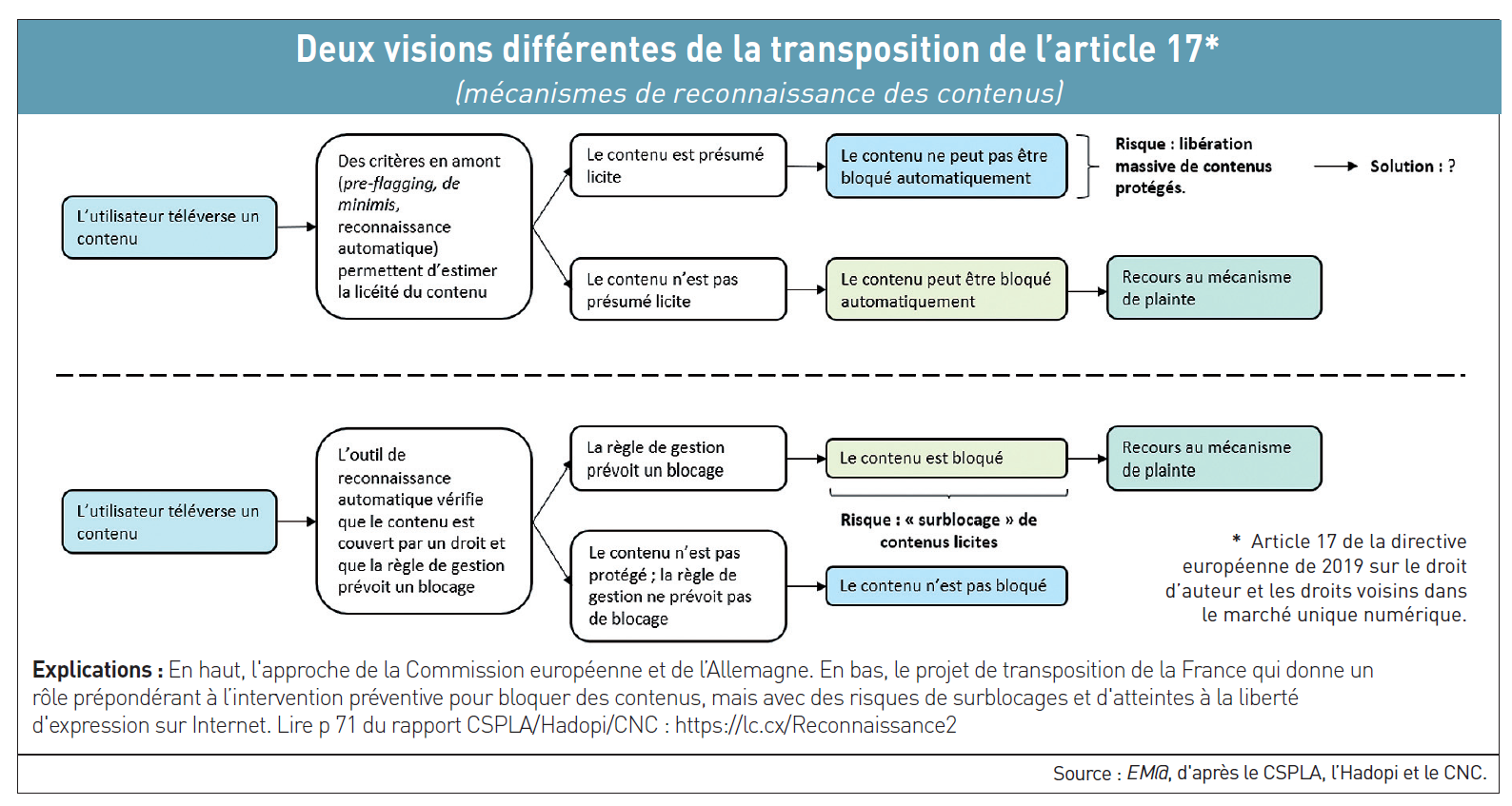

La dernière réunion de négociation en date autour de l’article 17 controversé s’est tenue dans le plus grand secret – à huis clos – le 12 février dernier entre la DG Connect de la Commission européenne, des membres du Parlement européen et des représentants des Etats membres. Cette direction « Communications Networks, Content and Technology » (

La dernière réunion de négociation en date autour de l’article 17 controversé s’est tenue dans le plus grand secret – à huis clos – le 12 février dernier entre la DG Connect de la Commission européenne, des membres du Parlement européen et des représentants des Etats membres. Cette direction « Communications Networks, Content and Technology » (