Google et sa filiale YouTube négocient avec Universal Music l’autorisation d’utiliser pour son IA musical, MusicML, les données de la première « maison de disques ». Les autres majors, Warner Music et Sony Music, devront aussi trouver des accords. C’est plus une opportunité qu’une menace.

Le 21 août, YouTube a annoncé un accord avec Universal Music autour de l’IA musicale. Le Financial Times avait par ailleurs révélé le 9 août que sa maison mère Google et la première major mondiale de la musique enregistrée étaient en pourparlers pour autoriser que les mélodies et les voix des artistes soient exploitées par l’intelligence artificielle MusicLM (développée par Google) afin que celle-ci puisse créer de nouvelles chansons. Si ces négociations devaient aboutir, un accord de ce type serait une première pour l’industrie musicale qui, jusqu’à maintenant, voient plus ces IA génératives de musiques comme une menace pour elle.

Le 21 août, YouTube a annoncé un accord avec Universal Music autour de l’IA musicale. Le Financial Times avait par ailleurs révélé le 9 août que sa maison mère Google et la première major mondiale de la musique enregistrée étaient en pourparlers pour autoriser que les mélodies et les voix des artistes soient exploitées par l’intelligence artificielle MusicLM (développée par Google) afin que celle-ci puisse créer de nouvelles chansons. Si ces négociations devaient aboutir, un accord de ce type serait une première pour l’industrie musicale qui, jusqu’à maintenant, voient plus ces IA génératives de musiques comme une menace pour elle.

Accords avec Google et YouTube

Quel est l’impact de l’IA générative sur l’industrie musicale ? « Imaginez que quelqu’un vole tout ce qui a de la valeur à une entreprise et l’utilise pour lancer une entreprise pour lui faire concurrence. C’est exactement ce qui se passe avec beaucoup de grands modèles d’IA d’apprentissage automatique qui existent aujourd’hui. Il s’agit d’une concurrence déloyale classique. (…) Il y a un besoin urgent de “code de la route” approprié pour l’IA générative et nous vous encourageons à agir de manière décisive et sans délai », a déclaré le 12 juillet dernier Jeffrey Harleston (photo), directeur juridique et vice-président exécutif pour les affaires commerciales et juridiques d’Universal Music. Il était auditionné au Sénat américain par le sous-comité de la commission judiciaire du Sénat, sur le thème de « l’intelligence artificielle et la propriété intellectuelle » (1).

Que vous disent les artistes au sujet de leurs voix et de la musique utilisées sans leur consentement par des IA musicales ? « Les artistes sont naturellement bouleversés que leur nom, image, ressemblance ou voix soient volés et utilisés pour suggérer qu’ils ont dit, chanté, ou fait quelque chose qu’ils n’ont jamais fait, a-t-il répondu aux sénateurs qui l’auditionnaient. C’est une violation horrible de la vie privée, et comme cela pourrait nuire à la réputation de l’artiste, cela pourrait irrémédiablement nuire à leur carrière. La voix et la personnalité d’un artiste sont leur gagne-pain et les voler – peu importe le moyen – est mal ». Il a appelé les Etats-Unis à procéder à des modifications législatives pour assurer un développement éthique de l’IA, notamment musicale. Le directeur juridique d’Universal Music avance trois points pour une future « loi pérenne sur le droit d’auteur afin de s’assurer qu’elle résiste à une IA en constante évolution technologie » : édicter une loi fédérale sur le droit de publicité [ou droit à l’image, ndlr] pour assurer la protection de la propriété intellectuelle d’un nom, d’une image, d’une ressemblance ou d’une voix ; assurer la transparence des éléments d’apprentissage de l’IA et permettre au titulaire du droit de pouvoir consulter les enregistrements détaillés des entrées d’apprentissage, sans avoir à s’engager dans un litige ; exiger l’étiquetage des oeuvres essentiellement générées par l’IA. Mais sans attendre que le Congrès américain s’empare du sujet, Universal Music cherche à trouver un terrain d’entente avec les éditeurs d’IA générative, tout du moins avec Google qui l’a approché.

La filiale d’Alphabet est aussi entrée en contact avec Warner Music. Il ne resterait plus qu’à discuter avec Sony Music pour faire le tour des trois grandes majors de la musique enregistrée. Rappelons qu’en septembre 2016, le laboratoire Sony CSL (2) avec fait sensation sur YouTube en diffusant une « nouvelle musique » des Beatles baptisée « Daddy’s Car » (3) et créée par l’IA Flow Machines du japonais (4), les Beatles faisant partie du répertoire… d’Universal Music. La n°1 des majors – au siège social situé aux Pays-Bas mais ayant son siège opérationnel basé à Santa Monica en Californie – adhère en outre aux sept principes édictés par le groupe Human Artistry Campaign (5) lancé en début d’année. Il s’agit de défendre les droits des créateurs dans le développement des technologies d’IA.

Pour l’heure, Alphabet avance à grand pas dans la musique générée par l’intelligence artificielle : tant du côté de Google qui a présenté le 26 janvier sa propre IA musicale baptisée MusicLM (6) que du côté de YouTube qui a lancé le 21 août un incubateur d’IA musicale avec des artistes, des auteurscompositeurs et des producteurs d’Universal Music (7).

MusicLM (Google), une IA hi-fi

Google présente MusicLM comme « un modèle générant une musique haute-fidélité à partir de descriptions textuelles ou d’une mélodie fredonnées ». Cette IA génère de la musique à 24 kHz qui reste cohérente sur plusieurs minutes. Et la filiale d’Alphabet d’affirmer : « Nos expériences montrent que MusicLM surpasse les systèmes précédents en termes de qualité audio et d’adhésion à la description du texte » (8). Mais cette IA musicale prometteuse n’a pas encore été rendue accessible au grand public, le géant du Net ayant la prudence de demander l’autorisation des plus grandes maisons de disques pour ne pas être accusé de contrefaçon et de spoliation des artistes. Seuls de nombreux exemples de bandes sonores générées par MusicML ont été mis en ligne.

Meta se met en trois avec Audiocraft

Meta se met en trois avec Audiocraft

Google n’est pas le seul à s’aventurer sur le terrain du « text-to-music » puisque Meta a mis en logiciel libre (open source) son modèle de langage capable de générer des extraits musicaux, MusicGen. Meta (ex-groupe Facebook), qui avait présenté mi-juin dernier MusicGen comme étant légèrement supérieures à MusicLM en termes de performances, a présenté le 3 août sa panoplie IA appelée Audiocraft, composée non seulement de MusicGen, mais aussi d’AudioGen et d’EnCodec. « MusicGen, qui a été formé avec de la musique appartenant à Meta et spécifiquement sous licence, génère de la musique à partir d’entrées utilisateur textuelles, tandis qu’AudioGen, qui a été formé aux effets sonores publics, génère de l’audio à partir d’entrées utilisateur textuelles. Aujourd’hui, nous sommes ravis de publier une version améliorée de notre décodeur EnCodec, qui permet une génération de musique de meilleure qualité avec moins d’artefacts », explique Meta dans sa présentation. Les trois modèles de la suite Audiocraft sont disponibles à des fins de recherche, destinés aux chercheurs et aux praticiens. Cette ouverture devrait accélérer le développement de l’IA générative pour l’audio, lequel a pris du retard par rapport aux IA générative pour les images, la vidéo et le texte (ChatGPT, Midjourney, Bard, Dall·E 2, LLaMA, Stability AI, …). « Générer de l’audio hautefidélité de toute sorte nécessite la modélisation de signaux et de motifs complexes à différentes échelles. La musique est sans doute le type d’audio le plus difficile à générer car elle est composée de modèles locaux et de longue portée, d’une suite de notes à une structure musicale globale avec plusieurs instruments », fait remarquer la firme de Mark Zuckerberg (9).

Mais le tout-en-un proposé en open source par AudioCraft, pour la musique, le son, la compression et la génération, vise à faciliter l’innovation et la créativité musicales (composition, chanson, bande sonore, …), sans avoir à jouer une seule note sur un instrument. Meta estime même que « MusicGen peut se transformer en un nouveau type d’instrument – tout comme les synthétiseurs lors de leur apparition » (10). MusicGen a été formé sur environ 400.000 enregistrements avec descriptions textuelles et métadonnées, ce qui représente 20.000 heures de musique appartenant à Meta ou sous accords de licence. Pour l’heure, Meta ne fait état d’aucune négociation avec l’industrie musicale et encore moins avec les majors avec lesquels Google a, au contraire, pris langue. « Si vous voyez un exemple de musique UMG [Universal Music Group, ndlr] distribuée illégalement, n’hésitez pas à nous contacter à contentprotection@umusic.com », signale sur son site web (11) la première major dirigée par Lucian Grainge (photo ci-contre). C’est ce qu’on dû peut-être faire les deux artistes Drake et The Weeknd, produits par Universal Music, lorsqu’ils ont constaté en avril dernier qu’un « artiste » surnommé « Ghostwriter » (compositeur fantôme) a mis en ligne une musique avec voix s’inspirant de leur style musical. Les fichiers audio et vidéo de ce morceau de 2 minutes et 14 secondes ont été diffusés avec succès sur plusieurs plateformes de streaming musical (Spotify, YouTube/YouTube Music, Apple Music, TikTok, …), avant d’en être retirés après quelques jours. Un spécialiste américain estime que le morceau pourrait avoir été créé et promu à des fins de marketing viral par une start-up californienne Laylo (12), laquelle travaille avec des artistes musicaux et compte parmi ses investisseurs… Sony Music. Bien d’autres artistes musicaux ont été imités par des IA génératives à tendance mélomane. La chanteuse barbadienne Rihanna (signée elle aussi chez UMG) s’est par exemple étonnée au printemps de s’entendre chanter « Cuff It » de Beyoncé, via une « IA Rihanna » (13).

Le rappeur Ye (ex-Kanye West, ayant son propre label Good Music) n’a pas non plus été épargné par la déferlante IA musicale, avec les musiques « Hey There Delilah » de Plain White T’s et « Passionfruit » de Drake. Angèle, elle, s’est vue en août chanter en duo avec Gazo (14) sans son consentement. Les IA musicales Flow Machines, MusicGen, AudioGen, MusicLM, Riffusion ou encore Mubert n’ont pas fini de surprendre. Jeffrey Harleston compte sur les Etats-Unis pour résorber leur retard dans la réglementation de l’IA générative.

Les Etats-Unis derrière la Chine et l’UE

A la suite des auditions de cet été, le Congrès américain devrait légiférer sur l’IA d’ici la fin de l’année. A l’instar de la Chine (15), l’Union européenne (UE) a pris de l’avance dans l’élaboration de son « AI Act » qui est entré mi-juin en phase de discussion législative entre le Parlement européen et le Conseil de l’UE. « Les systèmes d’IA générative comme ChatGPT doivent mentionner que le contenu a été généré par une IA. (…) Des résumés détaillés des données protégées par le droit d’auteur utilisées pour la formation des IA devront également être rendus publics », prévoit le projet de règlement européen sur l’IA (16). Les IA génératives vont devoir s’accorder. @

Charles de Laubier

Meta Platforms ne parle pas explicitement de « métavers intelligent », mais ses investissements dans à la fois les mondes virtuels immersifs et l’intelligence artificielle en montrent la voie. La conférence Meta Connect des 27 et 28 septembre derniers a été un rendez-vous international axé sur « l’IA et les réalités virtuelle, mixte et augmentée » (1). Pour « repousser les limites de la réalité », Mark Zuckerberg (son avatar photoréaliste ci-contre) a payé de sa personne afin de donner vie à la « réalité mixte » – désignation qu’il préfère au terme réducteur « métavers ».

Meta Platforms ne parle pas explicitement de « métavers intelligent », mais ses investissements dans à la fois les mondes virtuels immersifs et l’intelligence artificielle en montrent la voie. La conférence Meta Connect des 27 et 28 septembre derniers a été un rendez-vous international axé sur « l’IA et les réalités virtuelle, mixte et augmentée » (1). Pour « repousser les limites de la réalité », Mark Zuckerberg (son avatar photoréaliste ci-contre) a payé de sa personne afin de donner vie à la « réalité mixte » – désignation qu’il préfère au terme réducteur « métavers ».

Ursula von der Leyen (photo) a fait l’impasse sur les mondes virtuels. La présidente de la Commission européenne, dont le mandat commencé en décembre 2019 se terminera en novembre 2024, n’a pas eu un mot sur le métavers européen dans son discours du 13 septembre (

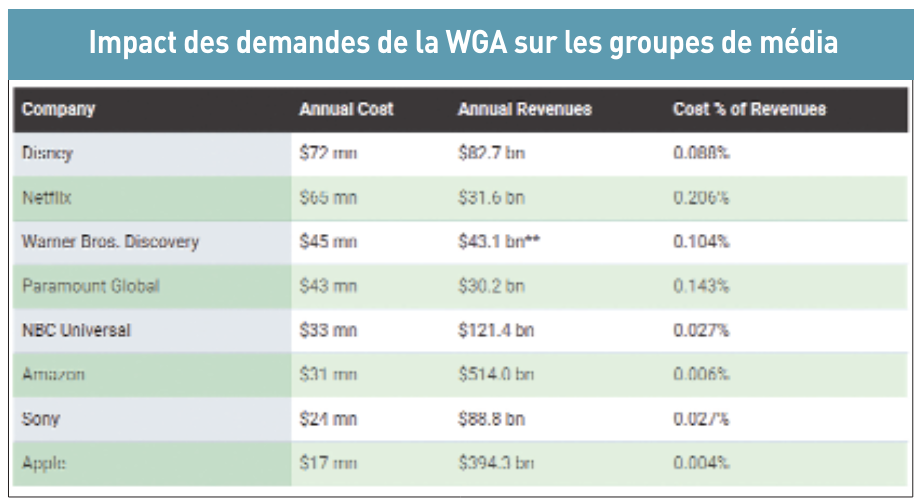

Ursula von der Leyen (photo) a fait l’impasse sur les mondes virtuels. La présidente de la Commission européenne, dont le mandat commencé en décembre 2019 se terminera en novembre 2024, n’a pas eu un mot sur le métavers européen dans son discours du 13 septembre ( Les scénaristes de la Writers Guild of America (WGA), en grève depuis le 2 mai, et les acteurs de la Screen Actors Guild and American Federation of Television and Radio Artists (SAG-AFTRA), en grève depuis le 13 juillet, sont très remontés contre l’Alliance of Motion Picture and Television Producers (AMPTP). Cette dernière regroupe les grands groupes de médias et de télévisions américains ainsi que des plateformes de streaming vidéo : « Amazon/MGM, Apple, Disney/ABC/Fox, NBCUniversal, Netflix, Paramount/CBS, Sony, Warner Bros. Discovery (HBO) et d’autres », mentionne le syndicat américain des comédiens. Le mouvement social s’étend aux éditeurs de jeux vidéo.

Les scénaristes de la Writers Guild of America (WGA), en grève depuis le 2 mai, et les acteurs de la Screen Actors Guild and American Federation of Television and Radio Artists (SAG-AFTRA), en grève depuis le 13 juillet, sont très remontés contre l’Alliance of Motion Picture and Television Producers (AMPTP). Cette dernière regroupe les grands groupes de médias et de télévisions américains ainsi que des plateformes de streaming vidéo : « Amazon/MGM, Apple, Disney/ABC/Fox, NBCUniversal, Netflix, Paramount/CBS, Sony, Warner Bros. Discovery (HBO) et d’autres », mentionne le syndicat américain des comédiens. Le mouvement social s’étend aux éditeurs de jeux vidéo. IA génératives : menaces de cannibalisation

IA génératives : menaces de cannibalisation Le 21 août, YouTube a annoncé un accord avec Universal Music autour de l’IA musicale. Le Financial Times avait par ailleurs révélé le 9 août que sa maison mère Google et la première major mondiale de la musique enregistrée étaient en pourparlers pour autoriser que les mélodies et les voix des artistes soient exploitées par l’intelligence artificielle MusicLM (développée par Google) afin que celle-ci puisse créer de nouvelles chansons. Si ces négociations devaient aboutir, un accord de ce type serait une première pour l’industrie musicale qui, jusqu’à maintenant, voient plus ces IA génératives de musiques comme une menace pour elle.

Le 21 août, YouTube a annoncé un accord avec Universal Music autour de l’IA musicale. Le Financial Times avait par ailleurs révélé le 9 août que sa maison mère Google et la première major mondiale de la musique enregistrée étaient en pourparlers pour autoriser que les mélodies et les voix des artistes soient exploitées par l’intelligence artificielle MusicLM (développée par Google) afin que celle-ci puisse créer de nouvelles chansons. Si ces négociations devaient aboutir, un accord de ce type serait une première pour l’industrie musicale qui, jusqu’à maintenant, voient plus ces IA génératives de musiques comme une menace pour elle. Meta se met en trois avec Audiocraft

Meta se met en trois avec Audiocraft